1. sound source localization

소리가 이미지의 어디 부분에서 나는 소리인지 detection하여 heatmap으로 출력시키는 문제

image modal과 sound modal이 서로 reference하여 결론을 내리는 referencing model

소리의 context를 파악하여 image 내 object와 match하는 문제

여러 마이크에서 나오는 소리라면 위치를 찾는건 사실 큰 의미 없는데 하나의 마이크에서 여러 소리가 나오면 소리의 근원을 detection하는 것은 의미 있을 수 있다.

2. 구조

audio network에서는 sound embedding vector를 사용했지만

image network에서는 채널 공간정보가 남은 feature map을 사용

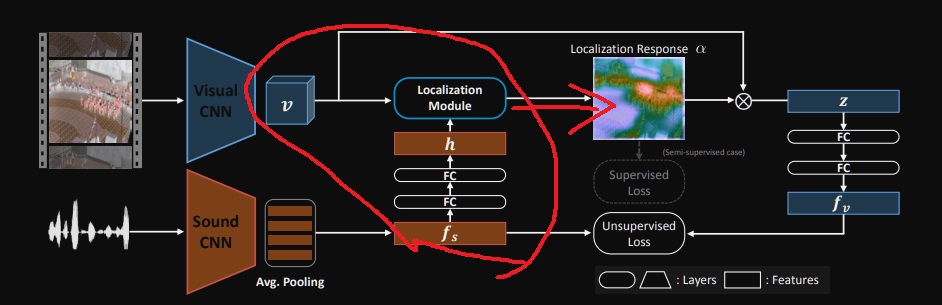

image frame을 CNN visual network에 넣어 채널, 공간정보를 가지는 feature map v를 추출

audio data를 CNN audio network에 넣어 sound feature vector $f_{s}$를 추출

$f_{s}$를 fully connected layer에 2번 넣어 sound embedding vector인 h를 추출

image feature map과 sound embedding vector를 attention model인 localization module에 넣고 localization score map을 출력

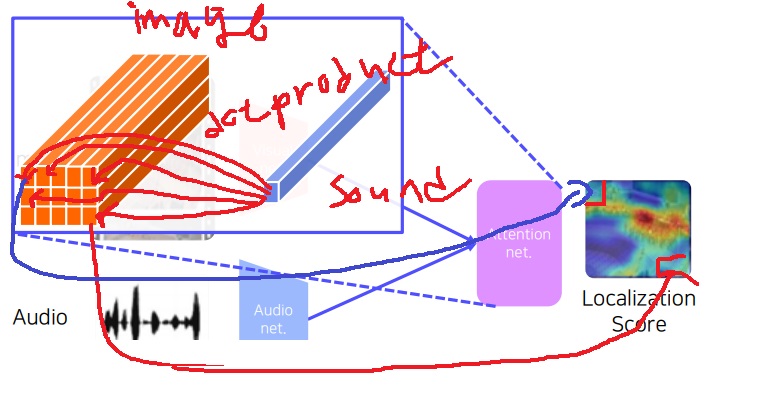

3. attention module

sound fixed dimension vector를 image feature map에 각 위치별로 내적시켜(마치 convolution 연산을 하는 것처럼)

위치별로 attention score(inner product value)를 계산하여 localization score map을 출력

내적을 하는 이유는 두 feature의 유사성을 측정해주니 적절하다.

각 위치별로 내적(convolution 연산)하면 채널은 1이 되겠죠?

내적이 큰 위치는 빨간색으로?

참고로 논문에서는 단순 내적도 가능하지만 내적이 음수인 값은 없애버리는 방법도 제안했음

4. fully supervised learning

ground truth로 localization score map을 가지고 있다면

KL divergence loss나 cross entropy loss(논문에서 언급)나 L2 norm(논문에서 언급)등으로 학습 가능

예측한 localization map이 ground truth localization map으로 출력되기를 바라도록 fully supervised learning이 가능

5. unsupervised learning

예측한 localization score map과 visual network에서 나온 feature map v를 weighted sum을 하여

attended visual feature vector(z)를 구함

visual feature vector를 fully connected layer에 2번 보내서 visual embedding feature인 $f_{v}$를 구함

video는 항상 image와 그에 대응하는 sound를 pair로 가지는 paired data라고 볼 수 있다.

이것은 $f_{v}$,$f_{s}^{+}$라고 표시하자.

image와 sound가 대응하는 pair이면 positive pair, 아니라면 negative pair라고 부른다.

negative pair은 $f_{v}$, $f_{s}^{-}$라고 표시하자.

만약 image와 audio가 positive pair data라면 visual embedding feature인 $f_{v}$와

sound feature vector인 $f_{s}^{+}$ 사이의 거리는 가까울 것이고

negative pair라면 $f_{v}$와 $f_{s}^{-}$사이 거리는 멀 것이다.

그래서 $f_{v}$와 $f_{s}$의 metric learning을 이용하여 unsupervised learning이 가능하다.

6. 왜 metric learning이 가능한가?

sound feature vector $f_{s}$는 image 내에 존재하는 모든 sound의 전체적인 encoding

여기서 localization map과 visual feature map의 weighted sum이라는 것은?

localization map이 학습이 제대로 된 곳이라면 이미지에서 sound feature가 어디어디에 나타나는지 알려주는 정보라고 생각할 수 있다.

그렇다면 visual feature map이라는 것은 이미지의 정보를 encoding한 것으로

둘을 weighted sum을 해버리면 이미지내에 존재하는 sound feature를 encoding한 것이나 다름 없다!

그래서 사실상 의미적으로 둘은 유사한 결과를 나타낸다고 할 수 있으므로

sound feature vector $f_{s}$와 localization map과 visual feature map의 weighted sum 사이 거리가 가까웠으면 하도록 학습하는 metric learning이 가능하다

7. semi-supervised learning

논문에서는 unsupervised loss와 supervised loss의 합을 이용하여 semi-supervised learning이 가능하다고 말하고 있다.

여기서 말하는 unsupervised loss와 supervised loss는 바로 위에서 설명한대로 구할 수 있다.

구체적으로는 unsupervised loss+(가중치)*supervised loss= semi-supervised loss

'딥러닝 > Computer Vision' 카테고리의 다른 글

| triplet loss 개념 알아보기 (0) | 2024.09.14 |

|---|---|

| visual and audio cross modal reasoning2 - speech separation, lip move generation (0) | 2024.09.10 |

| 3D task를 위한 dataset과 3d task (0) | 2024.07.08 |

| 3D 이해하기2 - 3D를 표현하는 방법 (0) | 2024.05.08 |

| 3D 이해하기 - 우리는 세상을 어떻게 관찰하는가? (0) | 2024.05.08 |