1. RetinaNet 구조

backbone인 ResNet에서 feature를 뽑아감

low level feature와 high level feature를 모두 활용하기 위한 3단? Feature pyramid network 활용

심지어 multi scale object detection에 더욱 잘 대응하기 위해 각 단계에서 모두 detection을 사용

각 단계에서 2가지 branch로 들어가는데 각각 object classification과 box regression을 수행한다

ResNet에서 feature를 뽑아가면서 마지막 단계의 feature부터 low level feature를 다시 합쳐나간다

합쳐나가는건 concat이 아니라 더하기

심지어 각 단계에서 모두 object classification과 box regression을 수행

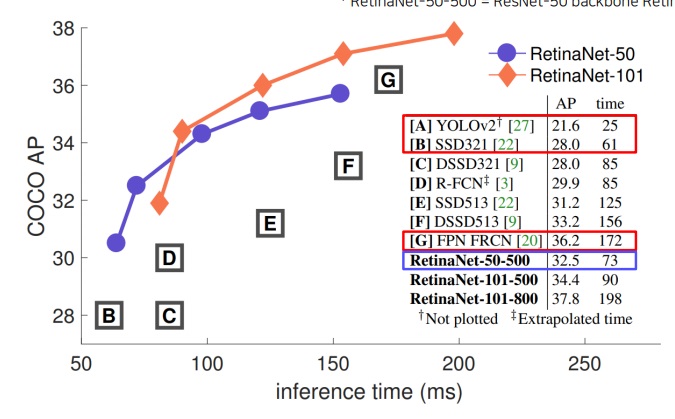

1-2) RetinaNet 성능

성능은 당시 나온 object detection 모델에서 거의 제일 좋다고 봐도 된다.. 속도도 준수한편

2. DETR(DEtection TRansformer)

2-1) motivation

NLP에서 큰 성공을 거둔 transformer를 computer vision task에 적용하기 위한 노력들이 진행중

구글의 Vision Transformer(ViT)

페이스북의 Data-efficient image Transformer(DeiT), DEtection TRansformer(DETR)

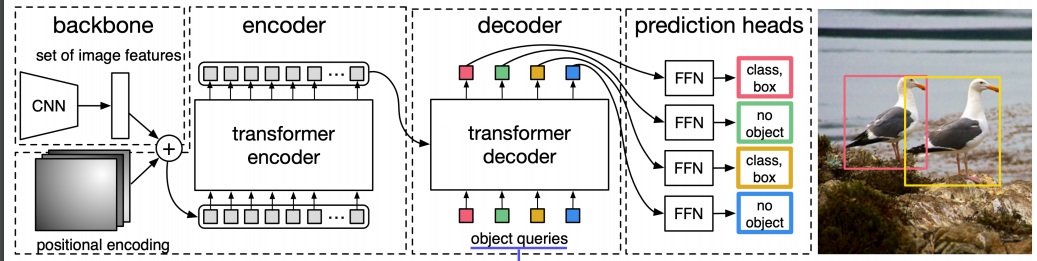

2-2) 구조

CNN에서 feature map을 뽑는다.

sequence로 만들기 위한 positional encoding을 더하여 transformer encoder에 넣어줌

최종 encoder vector를 transformer decoder에 넣어주고 학습된 positional encoding으로 decoder에 하나씩 넣어줌

쉽게 생각해서 decoder에는 이 위치의 object가 무엇인지 위치 token을 넣는다고 생각

언어를 생성하기 위해 token을 넣듯이 이 위치의 object는 무엇인지, 있다면 box가 적절한지, 아니면 object가 없는지를 예측

object query는 한 이미지에 object 최대 N개가 있다고 생각하고 N개의 query로 구성하는 것임(hyperparameter)

'딥러닝 > Computer Vision' 카테고리의 다른 글

| CNN visualization2 - layer activation & class visualization (0) | 2023.06.20 |

|---|---|

| CNN visualization1 - First filter visualization (0) | 2023.06.18 |

| single shot multibox detector 간단하게 다시 살펴보기 (0) | 2023.05.15 |

| Deeplab에 사용된 핵심 아이디어 살펴보기 (0) | 2023.05.14 |

| U-Net의 핵심 아이디어 파악하기 (0) | 2023.05.14 |