1. introduction

semantic segmentation 모델인데 conditional random field나 atrous convolution 등 특별한 기술을 사용함

2. conditional random field

일반적인 Neural network는 의외로 semantic segmentation 결과로 경계를 잡지 못하는 흐릿한 결과를 출력함

왜냐면 segmentation output과 input사이 feedback을 하기 어려워서 그렇다

(segmentation map이 ground truth로 있는 경우는 드무니까)

그래서 pixel을 node로 봐서 연결한 그래프를 형성하고 이것을 최적화 잘하여 이미지에서 경계선을 일단 찾고자함

그래서 일단 얻은 rough한 출력 map에 input 이미지에서 얻은 경계선을 잘 확산시켜서 멋지게 출력맵을 만들어내는 기술

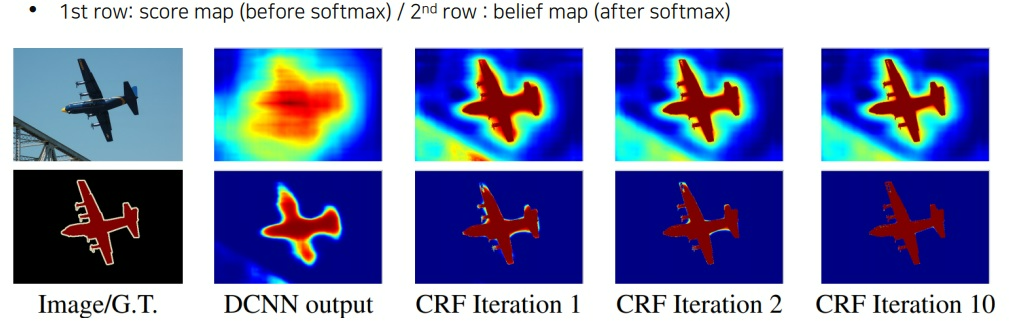

첫번째 줄은 softmax를 취하기 전인 score map이고 softmax를 취하면 두번째처럼 나온다고 한다

CRF를 반복할수록 더욱 멋진 segmentation 이미지가 나타난다

3. atrous convolution

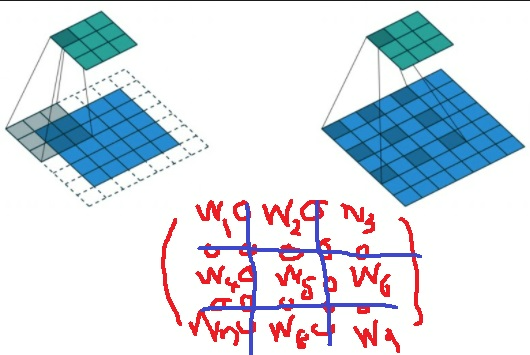

dilated convolution이라고도 부른다

kernel 원소 사이에 zero padding을 넣어 일반적인 convolution이 보는 영역보다 더 넓은 영역을 보도록 receptive field를 지수적으로 증가시킨다

그런데 parameter는 변하지 않는다 왜냐하면 weight로 zero padding을 넣었으니까

그런데 당연하지만 참고하는 영역만 넓어질 뿐 그 영역 내 모든 정보를 가져오지 못하는 것(sparse하게 feature를 잡는 것)은 분명 단점이긴 함

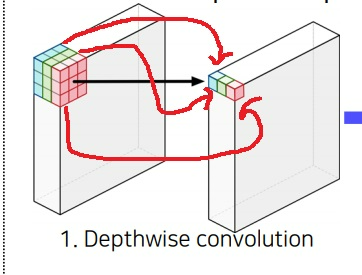

4. depthwise separable convolution

일반적인 convolution은 filter를 채널축 전체에 걸쳐서 한번에 하나의 결과를 뽑아냄

depthwise separable convolution은 위 과정을 두단계로 나눠서 수행한다. 먼저 채널별로 내적 결과를 가져온다

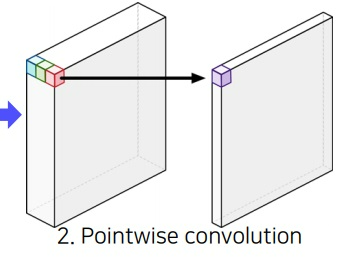

그리고 1*1 convolution 내적을 하듯이 내적을 수행함 그러면 일반적인 convolution이랑 동일한 결과를 얻음

그래서 기본적으로 일반적인 convolution의 표현력을 유지할 수 있다는 특징이 있다

큰 차이는 없는데 input과 output의 채널 크기가 비슷하면 계산량이 어느정도 감소한다고 알려져있다

Dk는 kernel의 size, Df는 feature map의 size

M은 input channel N은 output channel

항상 작은건 아니긴한데 비슷하다는 기준도 애매하긴하다

예전에 증명했는데 항상 계산량이 감소한다고

아무튼 몇개 넣어서 계산해보면 감소하는것 같긴해

5. deeplab v3+의 구조

가장 발전한 deeplab 시리즈

2년전 얘기라... 요새는 어디까지인지 모르겠네

image를 atrous convolution으로 receptive가 특별히 큰 feature map을 뽑는다

이미지 내 작은 물체, 큰 물체등을 고려한 atrous spatial pyramid pooling을 수행한다

연관된 주변 물체나 배경정보들이 모두 다르기 때문에 다양한 스케일에서 처리하고자 다양한 정도의 convolution을 수행하는 것이다.

이 결과를 upsampling하여 atrous convolution으로 뽑은 low level의 feature와 concatenation하여 최종 output을 prediction

atrous convolution과 pyramid pooling과 low level, high level feature fusion 기법을 사용하였다

'딥러닝 > Computer Vision' 카테고리의 다른 글

| object detection 모델인 RetinaNet과 DETR(DEtection TRansformer) 핵심 아이디어 (0) | 2023.06.17 |

|---|---|

| single shot multibox detector 간단하게 다시 살펴보기 (0) | 2023.05.15 |

| U-Net의 핵심 아이디어 파악하기 (0) | 2023.05.14 |

| 유명한 CNN구조 AlexNet, VGGNet, GoogleNet, ResNet 복습 재활 (0) | 2023.05.12 |

| convolution위치를 변형시키는 deformable convolution (0) | 2023.05.11 |