1. MSE loss(mean square error)

regression 문제에서 사용하는 가장 대표적인 loss function

L2 norm을 사용한다고 해서 L2 loss라고도 부른다.

true value와 predicted value의 제곱합의 평균이다.

$$MSE= {\sum _{i=1} ^{n} \frac{(y _{i} -y _{i}^{p} ) ^{2}}{n}}$$

root를 씌운 RMSE(Root Mean squared error)를 종종 쓰기도 한다.

$$RMSE= \sqrt [2]{\sum _{i=1} ^{n} \frac{(y _{i} -y _{i}^{p} ) ^{2}}{n}}$$

풀기 쉽다는 이유에서 가장 많이 쓰인다. 미분을 하기 쉬워서, 최적화하기가 쉬워서 자주 쓰인다.

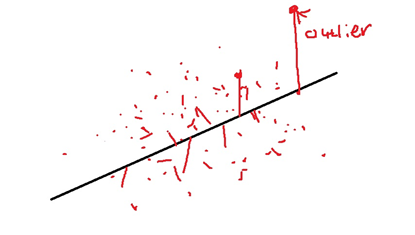

그러나 outlier에 크게 의존한다는 점이 특징이다.

true value가 매우 크면 제곱을 하는 경우 predicted value와의 차이가 훨씬 커진다. 그래서 loss도 그만큼 커진다는 것이다.

2. MAE loss(mean absolute error)

outlier 때문에 MSE loss의 대안으로 나온 것이 MAE loss다.

L1 norm을 사용해서 L1 loss라고도 부른다.

특징이 절댓값을 사용하여 true value가 매우 큰 경우에도 MSE에 비해 덜 영향을 받는다는 점이 특징이다.

물론 문제점도 있다. 그래프를 보면 알겠지만 loss가 적은 곳에서도 gradient가 매우 크다는 점이다.

그리고 minimum에서는 이론적으로 미분가능하지 않다는 것도 사실 문제다.

이것을 보정하기 위해서 learning rate를 크게 잡아 빠르게 minimum에 도달하게 만든다고 한다.

'딥러닝 > 딥러닝 기초' 카테고리의 다른 글

| L1 regularization(Lasso)과 L2 regularization(Ridge) (0) | 2021.12.15 |

|---|---|

| regularization이란 무엇일까? (0) | 2021.12.15 |

| 가장 좋은 loss function은? (0) | 2021.11.22 |

| cross entropy loss(=log loss)에 대한 고찰 (0) | 2021.11.20 |

| loss function에 대하여 (0) | 2021.11.19 |