1. naive bayes classifier의 문제점

만약 test sentence d내에 존재하는 특정 단어 $w_{i}$가

train data에서 특정 class C=c내에 1번도 존재하지 않으면

$P(w_{i}|c)$는 0이므로 test의 sentence d는 다른 단어의 조건부확률과 무관하게 무조건 P(c|d)=0이다.

다른 단어는 다 존재하지만 단 하나의 단어만이라도 이런 경우가 발생하면

무조건 예측확률이 0이라는 사실이 굉장히 억울한 부분이다.

2. laplace smoothing

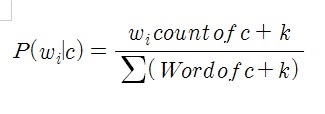

특정 class C=c에 test내 특정 단어 $w_{i}$가 속할 조건부확률을 laplace smoothing을 이용하여 구하면

그러니까 원래 구하는 식에 smoothing 상수 k를 더해준 것

상수 k는 확률에 크게 영향을 주지 않는 선에서 적절한 값을 선택하면 된다.

보통 1을 쓸 수 있는데 그것은 (없더라도) 최소 count 1은 보장하겠다는 것이다.

(없을수 있지만) 최소한 1개는 존재하겠다고 본다는 것이다. (add-1 smoothing)

728x90

'딥러닝 > NLP' 카테고리의 다른 글

| Word2Vec의 기본 알고리즘 (0) | 2022.02.06 |

|---|---|

| Word2Vec의 핵심 아이디어 (0) | 2022.02.05 |

| Naive bayes classifier의 개념과 핵심 아이디어 (0) | 2022.01.30 |

| transformer은 NLP의 트렌드를 어떻게 바꾸었을까 (0) | 2022.01.28 |

| bag of word - 왜 단어는 숫자 벡터로 표현해야할까? - (0) | 2022.01.25 |