Introducing Instella: New State-of-the-art Fully Open 3B Language Models — ROCm Blogs

Alignment to human preferences and strengthen chat capabilities with direct preference optimization (DPO).

rocm.blogs.amd.com

https://discuss.pytorch.kr/t/amd-mi300x-gpu-instella-3b/6297

AMD, 자사의 MI300X GPU에서 학습한 소규모 언어 모델 Instella 3B 공개

Instella 3B 소개 AMD가 새로운 3B(30억) 파라미터 규모의 오픈소스 언어 모델 Instella를 발표했습니다. Instella는 AMD의 MI300X GPU에서 훈련된 최신 모델로, 기존의 오픈 모델보다 뛰어난 성능을 보여줍니

discuss.pytorch.kr

AMD가 새로운 3B(30억) 파라미터 규모의 오픈소스 언어 모델 Instella를 발표했습니다.

Instella는 AMD의 MI300X GPU에서 훈련된 최신 모델로, 기존의 오픈 모델보다 뛰어난 성능을 보여줍니다.

라마3(Llama-3.2-3B), 제마(Gemma-2-2B), 그리고 Qwen-2.5-3B와 같은 오픈 가중치 모델(Open-weight models)과도 경쟁 가능한 수준의 성능을 보이고 있습니다.

특히, AMD는 이번 발표에서는 단순 모델 공개뿐만 아니라, 모델 가중치, 학습 구성, 사용된 데이터셋 및 코드까지 모두 오픈소스로 공개되어 누구나 모델을 분석하고 공개할 수 있도록 하였습니다.

AMD가 공개한, Instella 모델 공개의 목표는 다음과 같습니다:

- 완전 오픈소스화: 모델 가중치, 학습 과정, 데이터셋, 코드까지 전부 공개

- 경쟁력 있는 성능: 기존 3B 규모의 오픈 모델보다 우수한 성능 제공

- 최적화된 AMD GPU 활용: AMD Instinct MI300X에서 최적화된 학습 구조 적용

Instella는 단순한 단일 모델이 아니라, 4단계의 학습을 거친 모델 군으로 제공됩니다.

각 단계에서 언어 이해력과 문제 해결 능력을 강화하는 방식으로 학습된 것이 특징

Instella는 기존의 오픈소스 모델뿐만 아니라, 오픈 가중치 모델(Open-weight models)과도 경쟁할 수 있는 성능을 목표로 개발되었습니다.

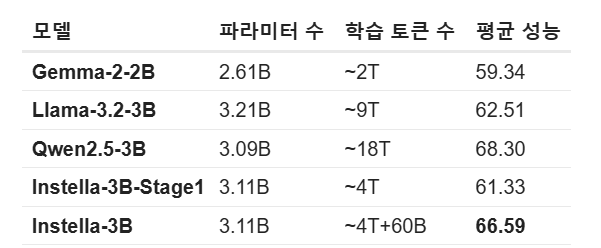

알려진 다른 모델들과의 모델 크기, 학습 토큰 수 및 벤치마크들의 평균 성능을 비교하면 다음과 같습니다

Instella 3B는 수학(MMLU, GSM8K) 및 문제 해결력(BBH, ARC Challenge)에서 기존 모델보다 뛰어난 성능을 보입니다.

또한, 학습에 사용한 토큰 수가 상대적으로 적음에도 불구하고, Llama-3.2-3B보다 4.08% 더 높은 평균 성능을 기록했습니다.

Instella 모델은 총 네 단계의 학습 과정을 거쳐 완성되었습니다.

이 과정은 크게 '두 단계의 사전 학습(Pre-training)'과 '두 단계의 지시 조정 및 정렬(Instruction tuning & Alignment)'으로 구성되며, 각각의 단계가 모델의 성능을 점진적으로 향상시키는 역할을 합니다.

먼저 사전 학습 단계에서는 대량의 데이터를 활용하여 언어 모델의 기초적인 능력을 구축하고 강화하며, 이후 지시 조정 단계를 통해 인간과의 상호작용 능력을 더욱 정밀하게 다듬습니다.

이를 통해 Instella 모델은 단순한 자연어 처리 능력을 넘어서, 지능적인 질문 응답, 복잡한 문제 해결, 그리고 사람의 의도를 이해하는 능력까지 갖추게 됩니다.

각 학습 단계는 정교한 데이터 선정과 최적화된 학습 기법을 활용하여 진행되었으며, AMD Instinct MI300X GPU를 기반으로 효율적인 대규모 학습이 이루어졌습니다.

1단계: 사전 학습(Pre-training) - 기본 자연어 이해 능력 구축

Instella 모델의 첫 번째 사전 학습 단계에서는 4.065조(Trillion) 개의 토큰을 활용하여 기본적인 언어 이해 능력을 학습했습니다.

이 과정에서 사용된 데이터는 OLMoE-mix-0924이며, 이는 DCLM-baseline과 Dolma 1.7과 같은 고품질 데이터셋을 조합하여 만들어졌습니다.

학습 데이터에는 코딩, 학문적 논문, 수학, 웹 크롤링을 통해 수집된 일반 지식 등 다양한 분야의 텍스트가 포함되어 있어, 모델이 폭넓은 언어적 배경을 학습할 수 있도록 구성되었습니다.

이 과정을 통해 Instella는 문맥을 이해하고, 논리적인 문장을 생성하며, 다양한 주제에 대한 정보를 처리하는 능력을 갖추게 되었습니다.

특히 FlashAttention-2, Torch Compile, bfloat16 혼합 정밀도 연산 등의 기술을 적용하여 메모리 사용량을 줄이면서도 학습 속도를 최적화하였습니다.

2단계: 사전 학습(Pre-training) - 문제 해결 및 논리적 사고 능력 강화

첫 번째 사전 학습을 마친 후, Instella는 57.575억 개의 추가적인 고품질 토큰을 활용한 두 번째 사전 학습을 수행하였습니다.

이 단계에서는 모델이 보다 복잡한 문제 해결과 논리적 추론을 수행할 수 있도록 성능을 강화하는 것이 목표였습니다.

사용된 데이터셋은 Dolmino-Mix-1124, SmolLM-Corpus, Deepmind Mathematics 등의 코드 및 수학 관련 데이터와, Tülu-3-SFT-Mixture 같은 대화 데이터가 포함되었습니다.

특히 GSM8k 데이터셋을 활용하여 수학적 문제 해결 능력을 강화하기 위해, Qwen2.5-72B-Instruct 모델을 이용하여 수학 문제를 Python 코드로 변환하고, 변수 값을 변경하는 방식으로 새로운 문제-정답 데이터를 생성하였습니다.

대화형 데이터셋의 경우, 질문-응답 쌍을 연결하여 사전 훈련 데이터로 활용했습니다.

우리는 이 데이터셋을 세 가지 다른 랜덤 시드로 학습한 후, 모델 가중치를 결합하여 최종 사전 훈련된 Instella-3B 모델을 완성했습니다.

이와 같은 과정을 통해 Instella는 기존 3B 규모의 공개 모델들과 비교했을 때 GSM8k 벤치마크에서 48.98% 향상된 성능을 보이며, 논리적 사고 및 문제 해결 능력에서 강한 우위를 점할 수 있었습니다.

3단계: 지도 학습 기반 지시 조정(Supervised Fine-Tuning, SFT) - 인간의 지시 수행 능력 강화

Instella의 세 번째 단계는 지도 학습 기반의 지시 조정(SFT, Supervised Fine-Tuning)으로, Instella-3B 모델을 기반으로 8.9억 개의 고품질 질문-응답 데이터를 활용하여 모델이 인간의 명령을 더 효과적으로 이해하고 수행할 수 있도록 학습했습니다.

이 과정에서 사용된 데이터셋은 SmolTalk, OpenMathinstruct-2, Tulu 3 Instruction Following 등으로, 다양한 분야의 질의응답 데이터를 포함하여 광범위한 질문 유형을 다룰 수 있도록 구성되었습니다.

특히 MMLU(다중 지식 벤치마크)와 같은 문제를 포함하여, 모델이 단순한 문장 생성뿐만 아니라 정확한 정보 전달, 논리적 사고, 명확한 설명 능력을 갖출 수 있도록 설계되었습니다.

이 단계를 거친 후 Instella는 인터랙티브한 환경에서 사용자의 질문을 더 자연스럽고 유용하게 처리할 수 있도록 개선되었으며, 대화형 AI 모델로서의 활용 가능성이 크게 향상되었습니다.

4단계: 선호 최적화(Direct Preference Optimization, DPO) - 인간 친화적 대화 최적화

마지막 단계에서는 Instella 모델이 인간의 선호도에 더욱 부합하는 출력을 생성할 수 있도록 Direct Preference Optimization(DPO) 기법을 활용한 학습을 수행했습니다.

이 과정에서는 OLMo 2 1124 7B Preference Mix 데이터셋에서 7.6억 개의 선호도 데이터를 학습하여, Instella가 보다 정제되고 자연스러운 대화 스타일을 갖추도록 조정되었습니다.

DPO 학습을 통해 모델은 응답의 품질을 개선할 뿐만 아니라, 불필요한 반복을 줄이고, 보다 논리적이며 명확한 답변을 제공할 수 있도록 훈련되었습니다.

또한, 사용자 입력 의도를 보다 정확하게 파악하여, 불필요한 정보를 제공하는 대신 정확한 정보 전달 및 친절한 대화 스타일을 유지하도록 조정되었습니다.

이 과정의 결과로, Instella-3B-Instruct 모델은 TruthfulQA(정확한 정보 제공), GPQA(지식 기반 질의응답), MT-Bench(대화형 평가) 등의 벤치마크에서 기존 공개 모델을 뛰어넘는 성능을 기록할 수 있었습니다.

Instella 모델 패밀리의 출시는 오픈소스 AI 발전과 AMD 하드웨어의 대규모 언어 모델 훈련 역량을 입증하는 중요한 도약을 의미합니다.

Instella 패밀리의 30억 개 파라미터 모델은 주요 벤치마크에서 현재 완전히 공개된 동급 크기 모델을 크게 능가하며, 공개 가중치를 제공하는 유사한 모델과 비교해도 경쟁력을 갖추고 있습니다.

이는 고품질 데이터 믹스 선택, 다단계 훈련 파이프라인, 그리고 대규모 훈련을 위한 고성능 Instinct MI300X GPU의 활용 덕분입니다.

Instella 모델의 가중치, 훈련 설정, 데이터셋, 코드까지 모두 오픈소스로 공개함으로써 AI 커뮤니티 내 혁신과 협업을 촉진하고자 합니다.

우리는 투명성, 재현 가능성, 그리고 접근성이 AI 연구 및 개발의 핵심 동력이라고 믿습니다.

개발자, 연구자 및 AI 애호가들이 Instella를 탐색하고, 개선에 기여하며, 언어 모델의 가능성을 확장하는 여정에 함께하길 바랍니다.

앞으로도 컨텍스트 길이, 추론 능력, 멀티모달 기능 등 다양한 차원에서 모델을 지속적으로 개선할 예정입니다.

또한, 모델과 데이터셋을 확장하는 한편, 다양한 아키텍처 접근 방식을 탐색할 것입니다.

Instella LMs 패밀리의 기능과 역량을 다룰 더 흥미로운 블로그도 기대해 주세요!

'AI 논문 > AI trend research' 카테고리의 다른 글

| A Review of DeepSeek Models' Key Innovative Techniques (0) | 2025.03.28 |

|---|---|

| Transformers without Normalization (0) | 2025.03.25 |

| The FFT Strikes Back: An Efficient Alternative to Self-Attention (0) | 2025.03.07 |

| SFT Memorizes, RL Generalizes: A Comparative Study of Foundation Model Post-training (0) | 2025.02.14 |

| The Illustrated DeepSeek-R1 (0) | 2025.02.01 |