1. abstract

전통적인 셀프 어텐션 메커니즘은 이차적(𝑂(𝑛²)) 복잡도를 갖기 때문에 긴 시퀀스에서 확장성이 제한됩니다.

우리는 FFTNet을 소개하는데, 이는 빠른 푸리에 변환(FFT)을 활용하여 𝑂(𝑛 log 𝑛) 시간 복잡도로 글로벌 토큰 혼합을 달성하는 적응형 스펙트럼 필터링 프레임워크입니다.

FFTNet은 입력을 주파수 도메인으로 변환함으로써, 파르세발(Parseval)의 정리가 보장하는 직교성과 에너지 보존 특성을 활용하여 장거리 의존성을 효율적으로 포착합니다.

학습 가능한 스펙트럼 필터와 modReLU 활성화 함수를 통해 중요한 주파수 성분을 동적으로 강조함으로써 기존의 셀프 어텐션을 대체할 수 있는 엄밀하고 적응적인 방식을 제공합니다.

Long Range Arena 및 ImageNet 벤치마크 실험을 통해 우리의 이론적 통찰이 검증되었으며, 고정된 푸리에 변환 기반 모델 및 기존 어텐션 모델보다 우수한 성능을 보였습니다.

2. introduction

전통적인 셀프 어텐션 메커니즘은 명시적인 쌍(pairwise) 연산을 통해 글로벌 상호작용을 포착하지만, 이로 인해 이차적(𝑂(𝑛²)) 연산 복잡도를 가지며 긴 시퀀스 처리에 부담이 될 수 있습니다.

이에 반해, 본 연구에서는 빠른 푸리에 변환(FFT)을 활용하여 글로벌 토큰 혼합을 수행하는 적응형 스펙트럼 필터링 프레임워크를 제안하며, 이는 수학적으로 우아하면서도 확장성이 뛰어난 접근 방식을 제공합니다.

우리 방법은 입력 시퀀스를 주파수 도메인으로 변환하는 것에서 시작하며, 이 과정에서 직교하는 주파수 성분들이 자연스럽게 장거리 의존성을 인코딩합니다.

이러한 변환은 연산 복잡도를 𝑂(𝑛 log 𝑛)로 낮추는 동시에, 파르세발(Parseval)의 정리에 의해 원 신호의 에너지를 보존합니다.

이를 통해 쌍별 비교 연산 없이도 효율적인 글로벌 상호작용을 가능하게 합니다.

이 프레임워크의 핵심 혁신은 학습 가능한 스펙트럼 필터의 도입입니다.

이 적응형 구성 요소는 글로벌 컨텍스트 벡터를 기반으로 푸리에 계수를 조절하여, 복잡한 패턴을 포착하는 데 중요한 주파수 대역을 동적으로 강조할 수 있도록 합니다.

또한, 필터링된 신호의 실수 및 허수 부분에 비선형 활성화 함수를 적용함으로써 모델의 표현력을 향상시켜, 단순한 선형 변환을 넘어서는 고차원 상호작용을 효과적으로 학습할 수 있습니다.

결과적으로, 우리가 제안하는 적응형 스펙트럼 필터링 프레임워크는 FFT 기반 변환의 연산 효율성과 컨텍스트에 적응하는 필터링 및 비선형 처리를 결합하여, 기존의 셀프 어텐션을 대체할 수 있는 강력하고 표현력 높은 솔루션을 제공합니다.

이를 통해 시퀀스 데이터에서 장거리 의존성을 모델링하는 데 최적화된 접근법을 제시합니다.

2.1 셀프 어텐션 복잡도

기존 Transformer 아키텍처(Vaswani et al., 2017)는 쌍별(dot-product) 어텐션을 사용하며, 이는 시퀀스 길이를 𝑛이라 할 때 𝑂(𝑛²)의 연산 및 메모리 비용을 초래합니다.

시퀀스 길이가 증가할수록 이와 같은 이차적 복잡도는 언어 모델링이나 장문 문서 이해와 같은 작업에서 처리 불가능한 수준으로 빠르게 증가하게 됩니다.

2.2 푸리에 변환 기반 혼합

푸리에 변환 기반 접근법은 빠른 푸리에 변환(FFT, Cooley & Tukey [1965])을 활용하여 토큰 간의 글로벌 혼합을 더욱 효율적으로 수행합니다.

예를 들어, FNet(Lee-Thorp et al. [2022])은 셀프 어텐션 서브레이어를 고정된 푸리에 변환으로 대체하여 연산 부담을 크게 줄였습니다.

그러나 이러한 정적 변환 방식은 입력 변화에 적응하거나 특정 작업에 중요한 주파수 성분을 강조하는 능력이 제한됩니다.

푸리에 변환 기반 기법은 언어 및 비전 태스크뿐만 아니라, 편미분 방정식(PDE)으로 표현되는 물리적 프로세스를 모델링하는 데에도 효과적임이 입증되었습니다.

Fourier Neural Operator (FNO, Li et al. [2021])는 푸리에 도메인에서 매개변수를 학습하는 신경망 구조를 통해 파라메트릭 PDE의 해 연산자를 학습할 수 있음을 보여주었으며, 해상도에 독립적인 성능과 빠른 추론 속도를 달성했습니다.

FNO는 주로 PDE 모델링 및 시뮬레이션을 위해 설계되었으나, 푸리에 표현을 활용한 효율적인 토큰 혼합이 딥러닝 응용 분야에서도 널리 활용될 수 있는 가능성을 시사합니다.

2.3 선형, 희소, 저순위 근사

푸리에 방법 외에도 셀프 어텐션의 비용을 줄이기 위한 여러 대안적인 전략이 존재합니다.

Performer(Choromanski et al. [2021]) 및 선형 Transformer 변형 모델(Katharopoulos et al. [2020])은 소프트맥스 어텐션 행렬을 근사하여 선형 또는 준선형 복잡도를 달성합니다.

한편, Reformer(Kitaev et al. [2020]), Linformer(Wang et al. [2020]), BigBird(Zaheer et al. [2020])는 희소(sparse) 또는 저순위(low-rank) 근사를 활용하여, 완전한 이차적 비용을 지불하지 않고도 효과적인 컨텍스트 길이를 확장합니다.

또한, Synthesizer(Tay et al. [2020]) 및 MLP-Mixer(Tolstikhin et al. [2021])와 같은 접근법은 명시적인 토큰 간 상호작용을 회피하고, 대신 고정된(fixed) 또는 학습된(learned) 혼합 연산을 적용하여 연산 비용을 줄이는 방식을 채택하고 있습니다.

2.4 컨볼루션 기반 접근법

또 다른 연구 흐름에서는 컨볼루션 모듈을 사용하여 셀프 어텐션을 대체하거나 보완함으로써 장기적인 의존성을 포착하려 합니다.

예를 들어, Hyena(Poli et al. [2023])는 계층적 컨볼루션 기반 프레임워크를 도입하여 긴 입력 시퀀스를 효율적으로 처리하면서도 어텐션의 표현력을 유지할 수 있도록 설계되었습니다.

또한, 경량화된(lightweight) 및 동적(dynamic) 컨볼루션(Wu et al. [2019]) 기법이 제안되어, 어텐션 헤드의 연산 비용을 줄이는 동시에 특징(feature)별 또는 시간 단위(time-step)별 커널을 학습하여 글로벌 상호작용을 근사할 수 있도록 하였습니다.

이러한 방법들은 기본적인(self-attention) 어텐션보다 더 나은 확장성을 보일 수 있지만, 매우 긴 컨텍스트를 효과적으로 처리하려면 정교하게 설계된 컨볼루션 아키텍처에 의존해야 한다는 한계가 있습니다.

2.5 직교 행렬 분해 방법

직교(orthogonal) 또는 유니터리(unitary) 변환은 안정적이고 효율적인 시퀀스 모델링을 위한 강력한 접근 방식을 제공합니다.

직교 분해의 주요 이점은 노름(norm)을 보존하는 성질로, 이를 통해 기울기 소실(vanishing gradient) 또는 기울기 폭발(exploding gradient) 문제를 완화할 수 있습니다(Wisdom et al. [2016]).

RNN의 맥락에서, 유니터리(unitary) 또는 직교(orthonormal) 재귀 가중치는 장기적인 의존성을 보존하면서도 표현을 안정적으로 유지하는 것으로 나타났습니다(Arjovsky et al. [2016], Lezcano-Casado and Martínez-Rubio [2019]).

다른 관점에서 보면, 이산 푸리에 변환(DFT) 자체도 (스케일링을 제외하면) 직교 변환의 한 형태이며, 명시적인 토큰 간 상호작용 없이도 전체 토큰을 글로벌하게 혼합할 수 있습니다. 위에서 논의된 FFT 기반 접근법은 이러한 직교 변환의 특수한 경우로 볼 수 있으며, 변환 행렬이 DFT에 의해 구조화됩니다.

더 일반적인 직교 변환(학습되거나 사전 설계된 것 모두)은 현대 아키텍처에서 연산 복잡도를 줄이거나 안정성을 향상시키는 용도로 제안되었습니다.

예를 들어, 학습 과정에서 직교성을 유지하도록 파라미터화된 빠른 직교 변환(fast orthonormal transforms) 기법이 연구되고 있습니다(Lezcano-Casado and Martínez-Rubio [2019]).

트랜스포머(Transformers)에서는 직교(orthogonal) 또는 유니터리(unitary) 블록을 채택하여 학습을 안정화하고 글로벌 구조를 캡처하는 시도가 이루어졌습니다.

그러나 이러한 방법이 반드시 O(n log n) 연산 비용을 달성하는 것은 아니며, FFT와 같은 방식과 동일한 효율성을 보장하기는 어렵습니다.

그럼에도 불구하고, 구조화된(structured) 또는 파라미터화된 직교 분해가 효율적인 글로벌 토큰 혼합 메커니즘으로 작용할 수 있음을 보여줍니다.

상태공간 모델(State Space Models, SSM)과의 관련성

최근에는 시퀀스 모델링을 위한 상태공간 모델(State Space Modeling, SSM) 접근법에서도 상당한 발전이 이루어졌습니다.

대표적인 예로, S4(Simplified Structured State Space) 및 그 확장 모델들이 있으며, 이들은 효율적인 연산을 가능하게 하면서도 장기적인 의존성을 효과적으로 처리합니다.

또한, **S5(Simplified State Space layer, Smith et al. [2023])**와 같은 더 단순화된 변형 모델은, 대각선 전이 행렬(diagonal transition matrix) 을 사용하여 시퀀스 차원에서 병렬 처리를 효율적으로 수행하면서도 높은 성능을 유지할 수 있음을 보여주었습니다.

이러한 연구들은 셀프 어텐션을 대체할 수 있는 방법을 찾기 위한 지속적인 노력을 반영하며, 특히 긴 시퀀스를 효율적으로 처리하면서도 표현력을 유지하는 것이 중요하다는 점을 강조합니다.

2.6 컨텍스트 내 적응형 스펙트럼 필터링

우리 연구는 기존의 고정된 푸리에 기반 기법 및 다양한 어텐션 근사 방법과는 다른 방향을 제시합니다.

우리는 주파수 도메인에서 학습 가능한 필터(learnable filter) 를 도입하여, 기존 FFT 기반 변환의 이론적 토대를 유지하면서도 유의미한 주파수 대역을 동적으로 재조정할 수 있도록 했습니다.

이러한 적응적 메커니즘은 파르세발(Parseval) 정리에 기반한 에너지 보존 특성을 유지하면서도, 입력 데이터에 따라 중요한 주파수 성분을 가중 조절할 수 있도록 설계되었습니다.

따라서, O(n log n) 복잡도를 유지하면서도 고정된 스펙트럼 혼합 방식보다 더 풍부한 표현력을 제공합니다.

순수한 근사 또는 희소 어텐션 메커니즘과 비교할 때, 적응형 스펙트럼 필터링은 이론적으로 타당하면서도 장기 의존성을 효율적으로 포착할 수 있는 직접적인 방법을 제공합니다.

기존 연구와의 차별점

우리의 접근 방식은 Guibas et al. [2022]의 Adaptive Fourier Neural Operators (AFNO) 와도 차별화됩니다.

AFNO는 채널 혼합을 위해 블록 대각 구조(block-diagonal structure) 를 사용하고, 가중치 공유(weight sharing) 방식을 적용하는 반면, 우리 방법은 완전히 다른 전략을 따릅니다.

구체적으로, 우리는 전역 컨텍스트 벡터(global context vector) 를 계산하여, 이를 푸리에 계수(Fourier coefficients) 에 직접 적용되는 학습 가능한 스케일링(scaling) 및 편향(bias) 파라미터로 변환한 후, 비선형 modReLU 활성화(modReLU activation) 를 수행합니다.

이 설계는 FFT 기반 혼합의 계산적 이점을 유지하는 동시에, 입력에 따라 중요한 주파수 대역을 동적으로 강조할 수 있는 표현력을 강화하는 역할을 합니다.

따라서, 우리의 적응형 스펙트럼 필터링 기법은 AFNO와 보완적인 대안을 제공하며, 효율성과 컨텍스트 의존적 특징 변조(adaptive, context-dependent feature modulation)를 동시에 실현합니다.

FNet, Performer, Sparse Transformer 등의 기존 연구는 고정적이거나 근사적인 토큰 혼합(token mixing) 방식을 통해 계산 비용을 줄일 수 있음을 입증하였습니다.

하지만, 우리의 적응형 스펙트럼 필터링 전략은 FFT의 효율성과 학습 가능한 입력 의존적 스펙트럼 필터를 결합함으로써, 복잡한 시퀀스 모델링(sequence modeling) 작업에서 필수적인 확장성(scalability)과 적응성(adaptability)을 동시에 확보하는 강력한 접근법을 제시합니다.

3. 적응형 스펙트럼 필터링 방법

이 섹션에서는 적응형 스펙트럼 필터링 프레임워크를 제안합니다.

이 방법은 글로벌 토큰 혼합(global token mixing) 에서 명시적인 토큰 간(pairwise) 상호작용이 필요하지 않도록 설계되었습니다.

기존의 내적(dot-product) 기반 자기어텐션(self-attention) 을 사용하는 대신, 우리는 이산 푸리에 변환(DFT, Discrete Fourier Transform) 을 활용하여 장기 의존성(long-range dependency) 을 효율적으로 포착합니다.

이후, 변환된 주파수 성분을 적응적으로 조정(adaptive modulation) 하고, 다시 역변환(inverse transform) 을 수행함으로써, 표현력(expressive power)과 계산 비용(computational cost) 간의 효과적인 균형을 달성합니다.

또한, 우리의 접근 방식은 강력한 이론적 보장(strong theoretical guarantees) 을 바탕으로 설계되었습니다.

3.1 Motivation

기존의 자기어텐션(self-attention) 메커니즘은 토큰 간(pairwise) 상호작용을 계산하며, 이는 시퀀스 길이(sequence length) 에 대해 O(n²) 연산 비용을 초래합니다.

따라서, 토큰 수가 증가할수록 연산 비용이 기하급수적으로 증가하여 현실적으로 적용하기 어려워집니다.

반면, 푸리에 변환(Fourier Transform) 은 시퀀스를 주파수 성분으로 분해하며, 본질적으로 글로벌 상호작용(global interaction)을 O(n log n) 시간에 인코딩할 수 있는 특성을 가집니다.

우리는 이러한 푸리에 변환의 장점을 살리면서도, 표현력(representational power)을 향상시키기 위해 주파수 도메인에서 학습 가능한 필터(learnable filter) 를 도입하였습니다.

이를 통해 계산 효율성을 유지하면서도 중요한 주파수 대역(salient frequency bands)을 강조할 수 있도록 설계되었습니다.

3.2 방법 설명 (Method Description)

입력 시퀀스 $X ∈ \mathbb{R}^{n × d}$가 길이 $n$과 임베딩 차원 $d$를 갖는다고 할 때, 우리의 방법은 다음 네 가지 단계로 구성됩니다:

1) 푸리에 변환 (Fourier Transform). 먼저, 토큰 차원을 따라 이산 푸리에 변환(Discrete Fourier Transform) 을 적용합니다:

$F = \text{FFT}(X) \in \mathbb{C}^{n \times d}$

이 컨텍스트는 다층 퍼셉트론(MLP)에 입력되어 주파수 빈과 어텐션 헤드를 기준으로 두 세트의 조정 매개변수, 즉 곱셈형 적응 스케일 $\Delta s$와 덧셈형 적응 바이어스 $\Delta b$를 출력합니다.

여기서 $\Delta s, \Delta b \in \mathbb{R}^{H \times f \times 1}$ (여기서 $H$는 헤드의 수, $f = \left\lfloor \frac{n}{2} \right\rfloor + 1$은 주파수 빈을 나타냅니다).

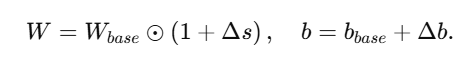

고정된 기본 필터 $W_{base}$와 기본 바이어스 $b_{base}$가 주어지면, 실제 매개변수는 다음과 같이 정의됩니다:

적응형 필터링 단계는 주파수 영역에서 다음과 같이 수행됩니다:

이것은 글로벌 컨텍스트에 따라 푸리에 계수를 재가중치하고 이동시킵니다.

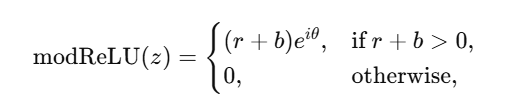

3) 비선형 활성화 (modReLU). 복소수 주파수 영역에서 더 높은 차원의 관계를 캡처하기 위해, 우리는 modReLU 활성화 함수를 적용합니다.

이는 복소수 $z = r e^{i \theta}$ (여기서 $r = |z|$이고 $\theta = \text{arg}(z)$)에 대해 다음과 같이 정의됩니다:

여기서 $b$는 학습 가능한 바이어스입니다.

이 연산은 크기에 대해 ReLU와 유사한 임계값을 적용하면서 위상은 보존하므로 주파수 영역 표현에 적합합니다. 요소별로 modReLU는 다음과 같습니다:

이 과정은 주파수 도메인에서 적응형 필터링과 비선형 변환을 통합한 전역적으로 혼합된 표현을 생성합니다.

3.3 푸리에 변환(FFT)을 자기 주의(attention) 방식에 대한 이론적 정당성

우리의 FFT 기반 적응형 스펙트럼 필터링 접근법은 기존의 자기 주의 방식에 비해 몇 가지 장점을 제공합니다:

- 효율적인 전역 혼합: 입력을 주파수 성분으로 분해함으로써, FFT는 O(n log n) 시간 안에 전역 상호작용을 제공하며, 이는 O(n²) 시간이 걸리는 자기 주의 방식보다 훨씬 확장성이 뛰어납니다.

- 암시적이고 적응적인 주의: 적응형 스펙트럼 필터는 전역 컨텍스트 벡터에 의해 정보가 제공되는 주파수 도메인 마스크를 효과적으로 학습합니다. 이 마스크는 주의 가중치와 유사하게 중요한 주파수 밴드를 재조정하지만, 명시적인 쌍대 계산을 피합니다.

- 비선형성을 통한 더 큰 표현력: 푸리에 변환 자체는 선형이지만, 복소수 계수에 modReLU를 적용함으로써 표현 능력이 풍부해집니다. 이로 인해 모델은 순수 선형 연산이 놓칠 수 있는 복잡하고 고차원적인 패턴을 포착할 수 있습니다.

- 에너지 보존 및 안정성: 파르세발 정리는 입력 신호의 노름(에너지)이 FFT에 의해 보존됨을 보장합니다. 따라서 우리의 방법은 중요한 정보가 우연히 손실되는 것을 방지하여 안정성을 유지합니다.

주파수 도메인에서의 전역 혼합, 학습 가능한 스펙트럼 필터링 및 modReLU 비선형 활성화를 활용함으로써, 우리의 방법은 이론적으로 근거가 있으며 계산적으로 효율적이고, 자기 주의 방식에 대한 강력한 대안이 됩니다.

3.5 요약

본질적으로, 적응형 스펙트럼 필터링은 입력을 주파수 영역으로 변환하고, 학습 가능한 비선형 변조(modReLU)를 적용한 후, 변환을 역으로 수행하여 전역적으로 혼합된 표현을 얻습니다.

이를 통해 다음과 같은 이점을 제공합니다:

• 유리한 O(n log n) 복잡도

• 장기 의존성 모델링을 위한 강력한 메커니즘

• 자기 주의(attention)에 대한 효율적이고 표현력 있는 대안

3.7 증명과 이론적 보장

아래에서는 우리의 방법이 자기 주의(self-attention)의 효율적인 대체물로서 정당화되는 몇 가지 주요 이론적 특성을 설명합니다.

3.7.1 직교 분해를 통한 글로벌 믹싱

$X \in \mathbb{R}^{n \times d}$를 입력으로 두고, $F = \text{FFT}(X)$로 정의합시다.

유니타리 DFT 행렬 $F_n \in \mathbb{C}^{n \times n}$는 다음을 만족합니다:

$F_n^* F_n = nI$,

여기서 $F_n^*$는 공액 전치(conjugate transpose)이고, $I$는 항등 행렬(identity matrix)입니다.

이 직교성은 내적을 보존합니다:

$\langle X_i, X_j \rangle = \frac{1}{n} \langle F_i, F_j \rangle$,

이는 각 토큰이 모든 주파수 성분에 영향을 미친다는 것을 의미합니다. 따라서 이 변환은 O($n^2$)의 쌍(pairwise) 계산 없이 자기 주의와 유사한 방식으로 글로벌 상호작용을 인코딩합니다.

3.7.2 Parseval의 정리에 의한 에너지 보존

Parseval의 정리는 다음과 같이 말합니다:

$|X|_2^2 = \frac{1}{n} |F|_2^2$

적응 필터링과 활성화 후, 출력은 다음과 같습니다:

$Y = \text{IFFT}(\text{modReLU}(F \odot W))$

필터가 특정 주파수를 과도하게 증폭시키지 않는 한, $Y$의 에너지는 $X$의 에너지와 가까워져, 중요한 정보가 보존됨을 보장합니다.

3.7.3 표현력을 향상시키는 비선형 활성화의 역할

푸리에 변환은 본질적으로 선형이지만, 실제 데이터는 종종 비선형적인 패턴을 나타냅니다.

복소수 계수에 대해 직접적으로 modReLU를 사용함으로써, 우리는 토큰 도메인에서 더 복잡한 메커니즘이 필요할 고차 상호작용을 포착할 수 있습니다.

위상(phase)은 보존되며, 크기(magnitude)에 임계값이 적용되어 모델이 매우 표현력 있는 주파수 기반 특징을 학습할 수 있도록 도와줍니다.

3.8 합성곱 기반 방법과의 비교

단순히 글로벌 합성곱 필터를 적용한다고 해서 자동으로 자기 주의(attention)와 같은 동작이 이루어지는 것은 아님을 강조하는 것이 중요합니다.

글로벌 합성곱 커널은 원칙적으로 전체 시퀀스를 커버할 수 있지만, 일반적으로 위치마다 공유되는 고정되거나 제한된 커널 집합을 사용합니다.

반면, 자기 주의는 입력 시퀀스에 따라 달라지는 토큰 의존적인(쿼리-키) 상호작용을 계산하여 매우 적응적인 방식으로 동작합니다.

우리의 적응적 스펙트럴 필터링 접근법에서 학습 가능한 필터 $W$는 글로벌 컨텍스트 벡터 $c$에 의존합니다.

$c$가 추출되면, MLP 기반의 변조 $\Delta W$가 데이터를 의존적인 방식으로 주파수 필터를 변경하며, 이는 고정된 커널을 사용하는 대부분의 표준 합성곱 방법과 다릅니다.

또한, 주파수 도메인에서의 modReLU 비선형 활성화는 어떤 주파수 성분을 유지하거나 억제할지 적응적으로 제어할 수 있어, 입력마다 다른 합성곱 커널을 효과적으로 생성합니다.

이는 주파수 도메인에서 전적으로 구현되긴 하지만, 주의 메커니즘에서 볼 수 있는 적응성과 더 유사한 형태의 동적 합성곱을 제공합니다.

요약하자면, 우리의 방법은 주파수 도메인에서의 곱셈이 토큰 도메인에서의 합성곱과 연관된 합성곱 정리를 통해 글로벌 합성곱으로 볼 수 있지만, 그 핵심적인 혁신은 다음과 같습니다:

- 글로벌 컨텍스트 의존적인 필터 $W$

- modReLU를 통한 복소수 계수의 비선형 변조

- 입력에 따라 커널 형태를 적응시키는 능력

이 요소들은 우리의 스펙트럴 필터링 전략에 적응적이고 자기 주의와 유사한 능력을 부여하여 전통적인 합성곱 아키텍처를 넘어서는 성능을 발휘하게 합니다.

3.9 FNet과의 비교

FNet (Lee-Thorp et al., 2022)은 DFT를 사용하여 토큰을 혼합하고, 혼합을 위한 학습 가능한 파라미터를 모두 제거합니다.

그러나 FNet은 특정 입력 분포에 대한 적응이 부족합니다. 우리의 방법은 다음과 같은 핵심적인 차이점이 있습니다:

- 적응적 필터링: 고정된 DFT에 의존하는 대신, 우리는 글로벌 컨텍스트 벡터를 조건으로 하는 학습 가능한 필터를 도입하여 특정 주파수에 대한 입력 의존적인 강조를 가능하게 합니다.

- 비선형 활성화: 우리는 복소수 도메인에서의 활성화 함수인 modReLU를 통합하여 선형 변환의 범위를 넘어서는 고차원 현상을 캡처합니다.

- 강력한 이론적 기초: 우리의 분석은 에너지 보존(파르세발 정리)과 합성곱 정리를 사용하여 주파수 도메인에서의 곱셈을 글로벌 토큰 혼합과 형식적으로 연결합니다.

- 실용적인 확장성: 두 방법 모두 O(n log n)의 복잡도를 달성하지만, 우리의 적응적 필터링과 비선형 활성화는 최소한의 오버헤드를 도입하면서 표현력을 크게 향상시킵니다.

3.9.1 계산 효율성

FFT와 IFFT는 채널당 O(n log n)의 시간 복잡도를 가집니다.

우리의 적응적 필터링과 modReLU 단계는 각각 O(n)만 추가하므로 전체 비용은 FFT와 IFFT에 의해 지배됩니다.

이로 인해 긴 시퀀스를 처리할 수 있는 효율적이고 확장 가능한 방법이 되며, O(n²)인 자기 주의(attention) 메커니즘과 대조됩니다.

3.9.2 적응적 MLP 복잡도 완화 전략

우리의 스펙트럼 주의 모듈에서 적응적 MLP는 각 주파수 빈에 대해 변조 파라미터를 생성합니다.

여기서 빈의 수는 대략적으로 n² + 1입니다.

따라서 출력 크기는 시퀀스 길이 n에 따라 선형적으로 확장되어, 긴 시퀀스에서 계산 병목 현상이 발생할 수 있습니다. 우리는 이 문제를 완화할 수 있는 몇 가지 전략을 논의합니다:

- 주파수 빈 다운샘플링: 효과적인 접근법 중 하나는 풀링(pooling) 또는 서브샘플링(subsampling) 기법을 사용하여 주파수 도메인 표현에서 주파수 빈의 수를 줄이고, 이를 적응적 MLP에 입력하기 전에 처리하는 것입니다. 이 방법은 필수적인 스펙트럼 정보를 보존하면서 계산 비용을 낮춥니다.

- 파라미터 공유: 각 주파수 빈에 대해 독립적인 변조 파라미터를 생성하는 대신, 모델이 인접한 빈들 사이에서 파라미터를 공유할 수 있습니다. 이 방법은 인접한 주파수 성분들 간의 중복성을 활용하여 총 파라미터 수를 크게 줄일 수 있습니다.

- 저차원 근사: 고차원 주파수 표현을 저차원 하위공간으로 투영하여 적응적 MLP의 출력 크기를 감소시킬 수 있습니다. 이 전략은 중요한 스펙트럼 특징을 유지하면서 파라미터 수와 계산 오버헤드를 줄입니다.

이 기술들은 적응적 MLP의 표현 능력과 계산 효율성 간의 균형을 맞출 수 있는 실용적인 방법을 제공합니다, 특히 매우 긴 시퀀스를 처리할 때 유용합니다.

요약

적응적 스펙트럼 필터링은 다음과 같습니다:

- 푸리에 변환의 직교성(orthogonality)을 통해 글로벌 토큰 혼합을 달성합니다.

- 안정적인 표현을 위해 신호 에너지를 보존합니다.

- 주파수 도메인 형태의 동적 합성곱을 통해 자기 주의를 근사합니다.

- 복소수 도메인에서 고차원 상호작용을 캡처하기 위해 modReLU를 사용합니다.

- O(n log n) 시간 복잡도로 작동하여 O(n²) 주의 기반 방법보다 상당한 이점을 제공합니다.

4.2 Long Range Arena (LRA) 벤치마크

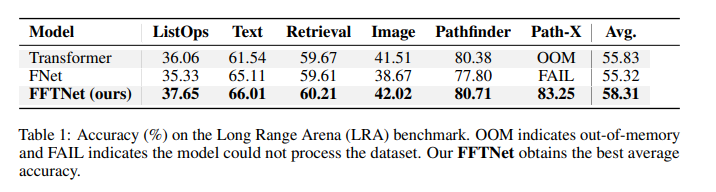

우리는 LRA에서 ListOps, Text, Retrieval, Image, Pathfinder, Path-X 등 6개의 작업에 대해 평가합니다.

표 1은 각 작업에서의 정확도(%)와 모든 작업에 대한 평균 성능을 보고합니다.

우리의 FFTNet 모델은 대부분의 작업에서 더 높은 정확도를 기록했으며, 특히 ListOps에서 37.65%의 정확도를 달성했습니다(표준 Transformer는 36.06%, FNet은 35.33%의 정확도).

전반적으로 FFTNet은 평균적으로 두 개의 기준 모델을 약간 능가합니다.

4.3 ImageNet 분류

다음으로, 우리는 FFTNetViT 변형 모델을 ImageNet 분류 작업에서 평가하고 이를 표준 ViT(셀프 어텐션)과 비교합니다.

표 2는 각 변형(Base, Large, Huge)에 대해 FLOPs와 Top-1, Top-5 정확도를 제시합니다.

명확성을 위해 대기 시간은 표에서 생략하고 별도의 그림으로 표시합니다.

특히, FFTNetViT는 비슷한 모델 크기에서 ViT보다 낮은 FLOPs를 달성하면서도 강력한 정확도를 유지하는 경우가 많습니다.

대부분의 실험에서 FNet은 ImageNet에서 두 방법 모두에 뒤처지므로, 우리는 우리의 접근 방식을 더 강력한 셀프 어텐션 기준 모델과 비교하는 데 집중합니다.

Ablation Study (구성 요소별 중요도 분석)

- FFTNet의 다양한 요소를 제거하며 모델의 성능에 미치는 영향을 분석함

- FFTNet의 주요 구성 요소를 제거할수록 정확도가 감소하는 경향을 보임

- 스펙트럴 게이팅 제거: 특정 주파수를 강조하는 기능이 사라지면서 정확도가 소폭 하락함

- 적응형 모듈 제거: 입력에 따라 필터를 동적으로 조정하는 기능이 사라져 정확도가 더 낮아짐

- FFT 대신 합성곱 사용: 글로벌 정보를 효율적으로 혼합하는 기능이 사라져 가장 큰 성능 저하가 발생함

- 이를 통해 FFTNet의 각 요소가 성능 향상에 중요한 역할을 한다는 점을 확인할 수 있음

결론

우리는 FFTNet을 제시하였으며, 이는 적응형 스펙트럼 필터링을 통해 셀프 어텐션의 본질적인 한계를 극복하는 새로운 접근 방식입니다.

우리의 방법은 입력을 주파수 영역으로 변환하고, 푸리에 이론을 활용하여 에너지 보존과 효율적인 전역 혼합을 보장합니다.

학습 가능한 스펙트럼 필터와 modReLU 활성화 함수의 통합은 모델이 중요한 주파수 대역에 동적으로 집중할 수 있게 하여, 복잡도를 O(n log n)으로 줄이면서도 표현력을 유지합니다.

LRA와 ImageNet에서의 광범위한 평가 결과, FFTNet은 경쟁력 있는 정확도를 달성할 뿐만 아니라 고정된 푸리에 접근 방식과 표준 셀프 어텐션에 비해 계산 효율성을 크게 향상시켰습니다.

이러한 결과는 이론적 기초와 적응형 학습 전략을 결합하여 확장 가능한 시퀀스 모델링을 가능하게 할 잠재력을 강조합니다.

.

'AI 논문 > AI trend research' 카테고리의 다른 글

| Transformers without Normalization (0) | 2025.03.25 |

|---|---|

| Introducing Instella: New State-of-the-art Fully Open 3B Language Models (0) | 2025.03.08 |

| SFT Memorizes, RL Generalizes: A Comparative Study of Foundation Model Post-training (0) | 2025.02.14 |

| The Illustrated DeepSeek-R1 (0) | 2025.02.01 |

| DeepSeek-R1: Incentivizing Reasoning Capability in LLMs viaReinforcement Learning (0) | 2025.01.31 |