1. sound tagging

sound를 통해 해당 장면들이 beach인지 classroom인지 어떤 장면인지 알아내는 문제

비디오 프레임과 소리를 받아 무슨 장면인지 tag를 구하는 문제

2. SoundNet

1) 구조

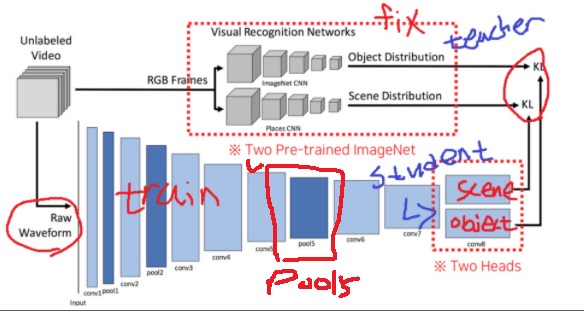

unlabeled video에는 RGB frame과 sound가 혼합되어있음

RGB frame을 object detection과 scene detection을 하는 pretrain된 두 visual recognition network(ImageNet CNN 계열)에 넣는다.

visual network는 fix되어 학습되지 않는다.

waveform을 CNN계열에 집어 넣어 feature를 뽑는다.

마지막 단에서 2개의 head로 분리되는데 하나는 scene recognition head와 하나는 object recognition head

RGB frame을 받은 pre-trained network의 object,scene detection feature와

waveform의 object,scene recognition head의 feature사이 2개의 KL divergence loss로 waveform CNN을 학습

RGB frame을 받는 pre-trained network는 teacher model이고

waveform을 받는 CNN은 teacher의 visual knowledge를 주입받아 학습하는 teacher-student model

pretrained visual network의 knowledge를 sound modality에 transfer하는 일종의 transfer learning

---------------------------------------------------------------------------------------------------------------------------------------------------

재밌는 점은 앞에서 주구장창 spectrogram을 사용한다고 말했지만 waveform을 사용했다는 점

이미 당시에 spectrogram보다 advance version들이 나왔는데도 그냥 waveform을 쓴것 같다고 한다

pre-trained visual network는 fix되어 학습되지 않는다. 오직 waveform을 받는 CNN만 학습

2) application

원하는 target task가 따로 있는 경우 다른 곳에 응용이 가능하다고 언급

학습이 된 SoundNet의 sound CNN에서 Pool5 부분의 feature를 따로 뽑아 target task classifier를 만들어 학습

학습된 SoundNet을 다른 target task에 응용하고 싶다면

중간의 Pool5 feature를 뽑아 target task classifier를 만들어 그 classifier를 학습

보통 fine-tuning을 할 때는 마지막 단의 feature를 사용하는데 왜 중간의 Pool5 feature를 사용했을까?

Pool5 feature가 sound의 일반화된 feature representation이라고 생각해서 그렇다.

마지막 단의 two head conv8 부분은 teacher model의 object detection, scene detection에 너무 optimize되어

다른 응용에는 사용하기 어렵다고 판단했다.(specific representation)

'딥러닝 > Computer Vision' 카테고리의 다른 글

| 3D 이해하기2 - 3D를 표현하는 방법 (0) | 2024.05.08 |

|---|---|

| 3D 이해하기 - 우리는 세상을 어떻게 관찰하는가? (0) | 2024.05.08 |

| pooling은 왜 사용하는가? (0) | 2024.04.23 |

| gray image의 channel은 1이 아니다 (0) | 2024.04.22 |

| object detection task, SPP Net, R-CNN, YOLO 간단하게 알아보기 (0) | 2024.04.17 |