1. motivation

다양한 타입, 형태, 특성을 가지는 데이터를 특별한 제한없이 모두 사용하여 모델을 학습시키는 방법

지금까지는 이미지 하나만을 사용해서 모델을 학습시켜왔지만 사실 사람들은 눈으로 보면서(이미지) 귀로 동시에 듣기(소리)도 하며

맛을 보기 전에도 코로 냄새를 맡는 등 자연스럽게 multimodal을 사용하는 것이 기본이다.

그 외에도 사람들은 social perception, 3D world의 depth perception등 느끼지는 못하지만

실제로는 사용하고 있는 다양한 감각들을 모두 사용하여 학습을 한다.

2. 어려운 점

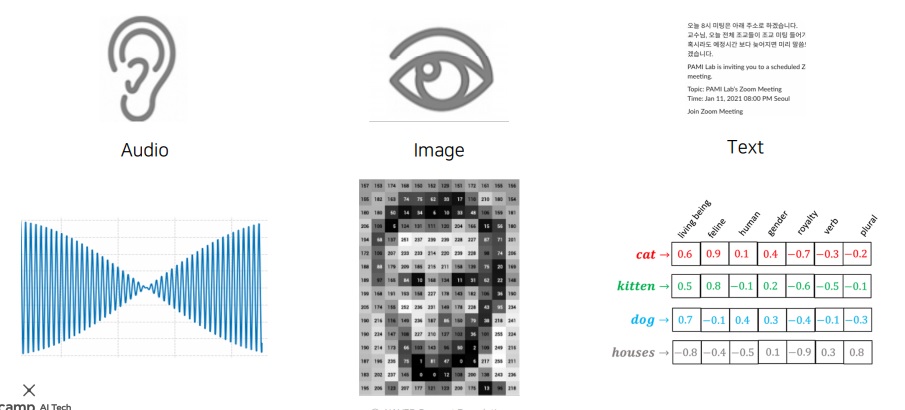

다양한 형태의 데이터를 사용하여 학습을 하고자하는데 여러 타입의 데이터를 표현하는 방법이 모두 다르다는 것이 문제다.

오디오는 1d signal waveform

이미지는 2d이상의 tensor로 표현

텍스트는 word 하나에 대응하는 embedding vector를 따로 구해야함

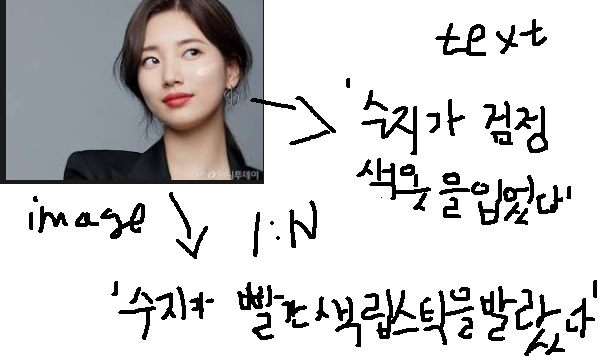

서로 다른 modality에 의한 정보 불균형부터 feature space의 특징조차도 불균형

’수지’라는 text하나가 표현할 수 있는 이미지는 무수히 많다

반대도 마찬가지다. 하나의 image가 표현할 수 있는 text는 무수히 많다

'수지가 검정색 옷을 입었다'

'수지가 빨간색 립스틱을 발랐다'

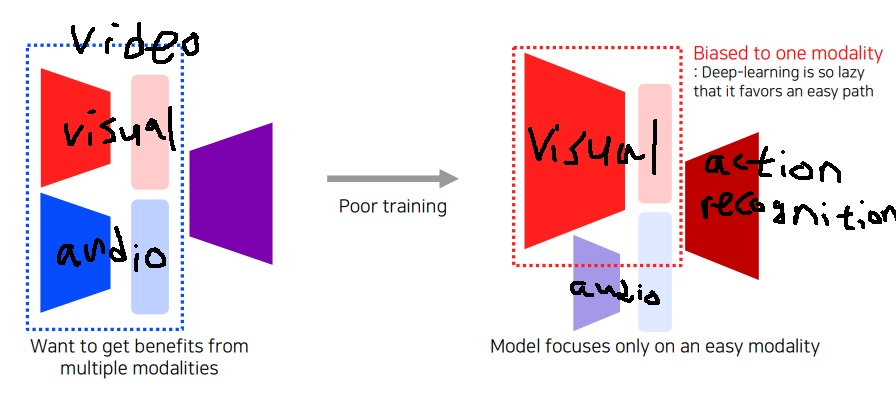

데이터가 있어서 여러 modality 사용하여 학습을 한다고 할 때 그 modality를 모두 공평하게 참조해서 좋은 정보를 잘 가져오느냐?

현실은 절대 그렇지 않다.

modality를 많이 사용하여 오히려 학습에 방해되는 경우도 많고

사람도 쉬운 것만 학습하려는 경향이 있듯이 하나의 modality에 편향되어 학습되는 경우가 많다.

Neural network는 일반적으로 visual 정보만 많이 사용하여 visual과 audio가 같이 들어오면 visual에 편향되어 학습되는 경향이 있다.

근데 생각해보면 사람도 마찬가지긴해 video를 받아 ‘action recognition’ task를 수행한다고 하자

보통 action은 시각으로 대부분을 판단하고 드물게 audio로 판단하기 때문에 시각으로 편향되어 학습된다.

3. multimodal learning의 여러가지 방법

어려운 점도 많지만 multimodal learning으로 기존에 하지 못하던 것들을 해결할 가능성을 제공해주고 있어 중요한 문제다.

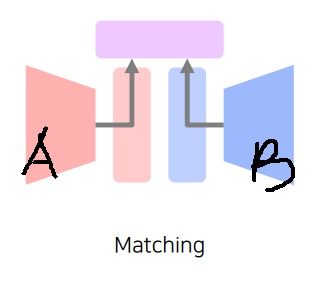

3-1) 서로 다른 modal에서 나온 데이터를 공통된 space로 보내 서로 match하여 학습하는 matching

3-2) 하나의 modality data를 다른 modality 데이터로 translation

3-3) modal A에서 modal A로 보내고 싶은데 modal B의 정보를 참조하여 더욱 결론을 잘 내리고 싶은 referencing

4. 예시 - self driving

다양한 타입의 데이터 sensor를 모두 합친 multimodal learning의 끝판왕?

어떤식으로 주행하고 어떤 식으로 상대방 차나 장애물 들을 회피할지 multimodal sensor를 통해 얻은 데이터를 종합하여 자동으로 결정

'딥러닝 > Computer Vision' 카테고리의 다른 글

| multimodal learning2 - show, attend and tell, visual question answering - (0) | 2023.07.05 |

|---|---|

| multimodal learning1 - image and text joint embedding (0) | 2023.07.03 |

| GAN loss의 단점을 극복하기 위한 Perceptual loss (0) | 2023.07.01 |

| 서로 관련없는 이미지로 바꿔버리는 CycleGAN의 핵심 아이디어 (0) | 2023.06.30 |

| image to image translation의 기본 모델인 Pix2Pix이 GAN의 약점 mode collapse를 어떻게 해결했는가 (0) | 2023.06.29 |