panoptic segmentation을 video에서도 사용하도록 만들고자 했다

1. 첫번째 단계

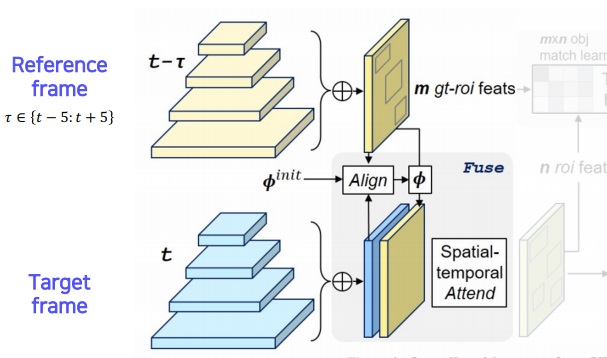

먼저 target feature map에 reference frame feature를 align시킨다(pixel fusion)

reference frame과 target frame에서 convolution하여 feature map을 뽑아 각 layer의 map을 전부 합쳐 각 frame에서 하나의 map을 뽑았다

motion map $\phi$는 $\tau$시간차 나는 두 frame 사이에서 각 pixel이 서로 대응되는 함수관계를 모든 pixel에 대해 가지는 map

초기 motion map과 reference feature map, target feature map을 align시켜 새로운 motion map을 만든다

새로 만든 motion map에 따라 reference feature map을 마치 t frame에서 나온 것처럼 만들어서 target feature map에 붙여준다

현재 target frame에서 보지 못하는 부분을 reference frame에서 가지고 올수있어서 더 높은 detection 성공률을 보일 수 있다

여러 frame이 합쳐지면서 시간 연속적인 smooth한 segmentation을 얻을 가능성도 높다

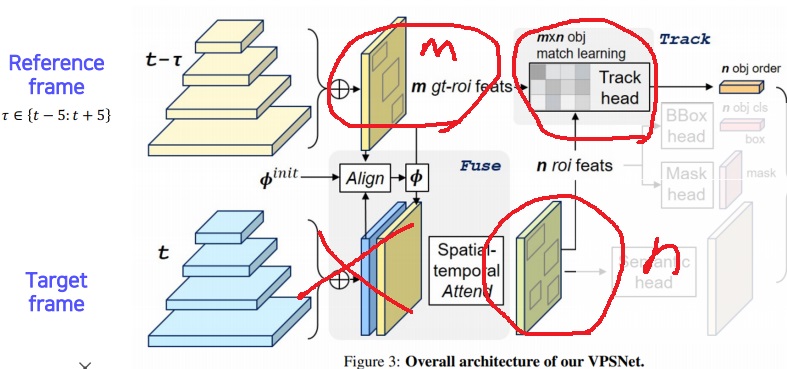

2. 두번째 단계

각 frame에서 Feature pyramid network(FPN)을 통해서 reference feature map에는 m개의 ROI를 얻고 (target + reference) feature map에는 n개의 ROI를 얻는다

m개의 ROI와 n개의 ROI 순서쌍 $r_{i}, r_{j}$에 대하여 fully connected layer에 집어넣어 $e_{i}, e_{j}$라는 vector를 뽑고

cosine similarity인 $cosine(e_{i}, e_{j})$를 (i,j)원소로 갖는 m*n 행렬인 track head를 얻는다

reference frame에서 가지는 object의 id와 target frame에서 가지는 object의 id를 연관시키는 작업

track head에서 reference frame의 ROI와 target frame의 ROI가 어떻게 연관되어있는지 확인

이렇게 만든 tracking head로부터 n개의 ROI의 reference frame과 어떻게 연관되는지 tracking한 order 정보를 뽑아낸다

3. 마지막 단계

n개의 ROI feature map으로 bounding box regression, classification, mask prediction을 수행

target+reference frame feature map으로부터 semantic map을 뽑는다

tracking head에서 뽑은 n개의 ROI에 대한 track order정보와 함께 위에서 구한 것을 모두 합쳐 Panoptic map을 뽑는다

video panoptic segmentation 결과를 보면 전경, 배경부터 서로 다른 물체도 구분하는 panoptic segmentation을 잘 수행하며

놀라운 점은 시간이 흐르면서 개별 물체의 segmentation이 유지되면서 부드럽게 추적을 잘함

'딥러닝 > Computer Vision' 카테고리의 다른 글

| image의 landmark를 추정하는 모델의 기본인 Hourglass Network (0) | 2023.06.25 |

|---|---|

| landmark localization task 기본개념 배우기 (0) | 2023.06.25 |

| CNN visualization6 - grad CAM - (0) | 2023.06.24 |

| CNN visualization5 - Class Activation Map(CAM) - (0) | 2023.06.24 |

| CNN visualization4 - guided backpropagation - (0) | 2023.06.22 |