1. 음성 합성, 딥러닝이 주도할까

음성 합성 분야는 딥러닝이 가장 빠르게 발전하는 분야이기도 합니다.

그동안 규칙 기반이 매번 통계기반, 특히 딥러닝에 주도권을 모두 내준 것처럼 음성 합성도 언젠가 딥러닝으로 교체되는 것은 시간문제라고 많은 이가 예상하죠.

최근에는 문장 전체를 딥러닝으로 합성하려는 시도도 많이 하고 있습니다.

이때도 성우의 목소리를 녹음한 데이터가 필요한 것은 동일합니다.

하지만 기존에는 정해진 문장을 녹음하고, 단순히 필요한 단어들을 조합하여 문장을 만들었다면

딥러닝을 이용한 음성 합성은 성우가 몇 시간 동안 자유롭게 녹음한 데이터를 학습해 어떤 문장이든 성우 목소리를 기반으로 합성해낸다는 차이가 있죠

물론 음성을 합성하는 일이 쉽지는 않습니다.

자연어는 억양이 오르내리고, 속도가 느려지다가 빨라지며 어떤 음절은 강세를 주고 어떤 음절은 가볍게 지나가기도 합니다.

구글에서 대화 디자인을 담당하는 언어학자 마거릿 어번(Margaret Urban)은 "흐름, 음조, 표현, 감정, 소리 크기, 속도 등 이 모든 것이 대화의 의미를 상대방에게 전달하는 요소입니다"라고 말했습니다.

말의 음조와 리듬을 조절하는 운율 역시 의미를 전달하므로 영혼 없는 기계 목소리처럼 들리지 않도록 하는 것이 매우 중요하다는 거죠.

이런 부분에서 딥러닝 기반의 음성 합성은 여전히 부족한 면이 많습니다.

아직은 사람이 직접 문장을 읽는 것만큼 자연스럽지 못하죠.

첫 부분만 들어도 "아 이건 기계가 읽는 문장이구나"라고 바로 알아차릴 수 있을 정도입니다.

2. 타코트론, 인간보다 더 자연스럽게

하지만 딥러닝은 점점 발전을 거듭하고 있고 음성 합성 모델 또한 나날이 정교해지고 있습니다.

특히 구글이 제안하고 엔비디아에서 구현한 음성 합성 모델 타코트론 2(Tacotron 2)는 사람과 거의 구분할 수 없을 정도로 자연스러운 음성을 합성해냅니다.

초기에는 운율 정보, 음향 정보, 음의 길이 같은 여러 매개변수의 값을 예측하는 단계에 머물렀고, 이를 조합해 음성을 생성했습니다.

하지만 타코트론2 같은 최신 딥러닝 모델은 이런 복잡한 과정을 생략하고 입력과 출력을 한번에 진행하는 End to End 방식을 채택해 보다 자연스러운 음성을 만들어냅니다.

중간 단계에 쓰였던 전문 지식을 요하지 않아 훨씬 더 쉽게 모델을 구축할 수 있죠.

1. 텍스트 > 멜 스펙트로그램(Tacotron 2)

2. 멜 스펙트로그램 > 음성(WaveNet)

음성을 합성하는 과정은 크게 두 단계입니다.

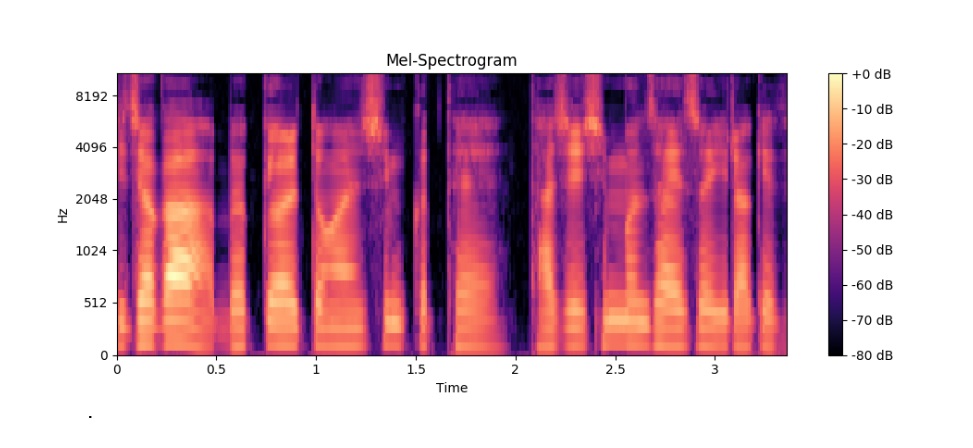

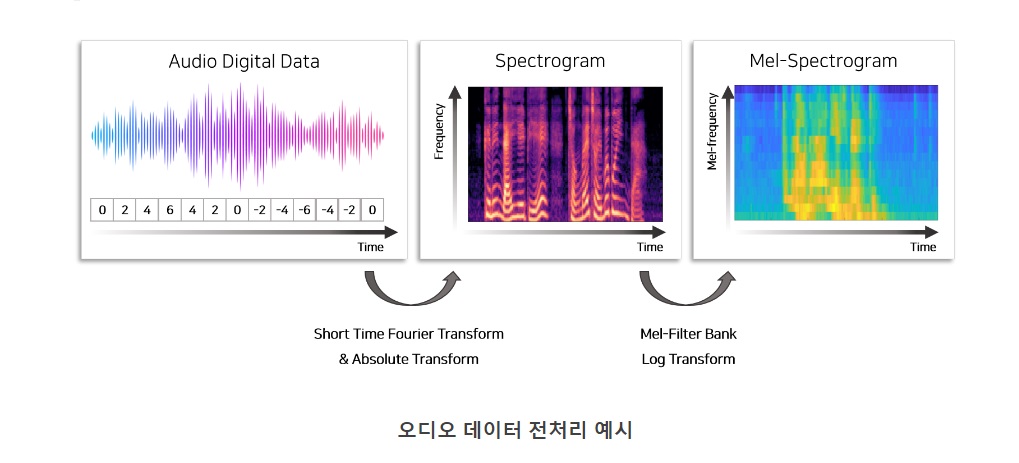

타코트론 2는 첫 번째 단계인 텍스트를 멜 스펙트로그램(Mel Spectrogram)으로 만드는 과정을 담당합니다.

멜 스펙트로그램이란 소리나 파동을 시각화하여 파악할 수 있도록 표현한 것으로,

음파와 비슷하게 생겼지만 색상의 차이, 농도를 포함해 보다 풍부한 정보를 표현할 수 있으며, 이를 인간이 인지할 수 있는 주파수 대역으로 변환해 낮은 해상도로 압축한 것을 말합니다.

----------------------------------------------------------------------------------------

멜 스펙트로그램은 주파수 단위를 멜 단위로 바꾼 스펙트럼을 말함

오디오 데이터를 fourier transform하고, mel scaling을 하고 log transform을 했다고 함

----------------------------------------------------------------------------------------

기존에는 이 과정 하나만 해도 상당히 복잡한 절차를 거쳐야 했으나, 타코트론2 같은 딥러닝 모델은 End to End 방식으로 이 과정을 단순화했습니다.

다음으로 멜 스펙트로그램을 실제 음성으로 바꾸는 작업이 필요합니다.

이 단계를 처리하는 기술을 보코더(Vocoder)라고 하며, 얼마나 노이즈 없이 깨끗하고 선명한 음질을 생성할 수 있는지가 이 기술의 핵심입니다.

원래 보코더 또한 복잡한 규칙으로 구현되었으나, 최근에는 보코더에도 딥러닝을 적용해 성능을 높이고 있습니다.

엔비디아의 타코트론2에는 엔비디아에서 자체 개발한 딥러닝 보코더를 함께 제공해 매우 깨끗한 음질을 들려줍니다.

최근에는 이 두 단계 방식마저 한 단계로 통합해 멜 스펙트로그램 추출 없이 텍스트에서 음성을 바로 생성하는 진정한 End to End 방식의 모델을 연구하고 있습니다.

3. 딥러닝이 바꿀 음성 인식의 미래는

이처럼 음성 합성 모델은 점점 단순한 형태로 변하면서 성능은 오히려 더 좋아지고 있습니다.

풍부한 표현력을 지닌 딥러닝의 힘이라고 할 수 있죠.

여러 사람이 음성 품질에 1점부터 5점까지 점수를 매겨 평가하는 방식인 MOS 테스트에서 사람이 직접 읽은 음성이 4.58점을, 타코트론2는 4.53점을 받았습니다.

이 정도면 사람인지 아닌지 거의 구분이 안 되는 수준입니다.

딥러닝 알고리즘은 계속해서 발전하고 있습니다.

이제 단순히 스크립트를 읽는 것을 넘어 어린 나이에 세상을 먼저 떠난 딸의 목소리를 재현한다거나,

성우가 맡았던 목소리 연기를 대신하기에 이르고, 오디오북 콘텐츠는 물론 영어회화 서비스에도 쓰입니다.

알파고가 인간을 능가한 것처럼 조만간 딥러닝이 사람보다 더 자연스러운 소리를 내게 될지도 모를 일입니다.

스마트 스피커가 말하는 과정을 다시 한번 정리해보면..

1. 사람이 질문하면 음성을 텍스트 문장으로 변환

2. 문장을 이해한 다음 명령을 생성

3. 명령으로 스킬을 실행한 다음에는 다시 문장을 만들어내고

4. 마지막으로 음성을 합성하여 문장을 소리내어 읽는다.

이것이 바로 스마트 스피커의 작동 방식입니다.

지금도 여러분의 곁에서 이러한 방식으로 작동하고 있습니다.

스마트 스피커는 항상 여러분의 말을 들어줄 준비가 되어 있습니다. 진정한 인공지능 비서를 꿈꾸면서 말이죠.

참조

[논문리뷰]Tacotron2 - 새내기 코드 여행 (joungheekim.github.io)

[논문리뷰]Tacotron2 - 새내기 코드 여행

[논문리뷰] - TACOTRON2 : Natural TTS Synthesis By Conditioning WAVENET On Mel Spectrogram Predictions, ICASSP 2018

joungheekim.github.io

Mel-spectrogram

딥러닝을 이용하여 음성 인식, 음성 처리, 화자 인식, 감정 인식 등에서 많이 쓰이는 음성의 특징 추출 방법에는 Mel-Spectrogram, MFCC가 있다. 그 중 Mel-Spectrogram에 대하여 어떻게 추출하여 쓸 수 있는

xangmin.tistory.com

'책 읽기 > 비전공자도 이해할 수 있는 AI지식' 카테고리의 다른 글

| 비전공자도 이해할 수 있는 AI지식 -언어의 모든 규칙을 알 수 있을까- (0) | 2022.12.13 |

|---|---|

| 비전공자도 이해할 수 있는 AI지식 -인간의 언어를 정복하기 어려운 이유- (0) | 2022.12.11 |

| 비전공자도 이해할 수 있는 AI지식 -컴퓨터는 사람의 명령을 어떻게 실행하는가- (0) | 2022.12.09 |

| 비전공자도 이해할 수 있는 AI지식 -컴퓨터가 글을 읽는 방법- (0) | 2022.12.08 |

| 비전공자도 이해할 수 있는 AI지식 -컴퓨터는 어떻게 사람의 목소리를 이해하는가- (0) | 2022.12.07 |