1. XGBoost 모델

gradient boosting의 약점은 train data에 대해 한없이 loss인 residual을 줄여나가니까 overfitting되기 쉽다는 단점이 있습니다.

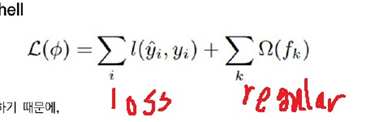

이런 단점을 인식하여 나온 방법이 XGBoost입니다. XGBoost는 실제 값과 예측 값의 차이를 일반적인 loss에 regularization term을 더하여 이것을 줄이는 방향으로 학습을 진행합니다.

loss function도 단순한 MSE같은 차이뿐만 아니라 다양한 loss function을 사용하여 task에 따른 유연한 튜닝을 가능하게 하였다고 합니다.

2. parameter norm penalty

parameter norm penalty 기법은 loss function에 norm penalty를 더하는 regularization방법입니다.

$$regularization=loss+lambda \times (norm\;penalty)$$

일반적인 식은 위와 같이 되는데 norm은 L1 norm과 L2 norm이 있습니다.

$\lambda$ 는 parameter에 penalty를 부여하는 정도로 크면 클수록 parameter를 더욱 축소시키는 경향이 있다고 생각하면 좋습니다.

L1 regularization은 weight들의 절댓값의 합인 L1 norm을 더하는 것을 말합니다.

L2 regularization은 weight들의 제곱의 합인 L2 norm을 더하는 것을 말합니다.

이 두 regularization은 중요한 차이가 있는데 penalty를 크게 부여할수록

L1 regularization은 대부분의 weight를 완전하게 0으로 보내는 성질이 있고 L2 regularization은 완전히 0은 아닌데 0에 가깝게 보내는 성질이 있습니다.

이 두 regularization을 전부 사용하는 방식을 elastic net이라고 부릅니다. elastic net은 전체 weight의 크기를 비슷한 분포로 만들어주는 group effect가 있다고 알려져 있습니다.

$$elastic=loss+\lambda _{1} \times (L1)+ \lambda _{2} \times (L2)$$

일반적으로는 L2 regularization과 elastic net이 좋다고 알려져 있으나 반드시 그렇지도 않습니다.

참고

https://hyunlee103.tistory.com/25

[머신러닝] Boosting Algorithm

처음 머신러닝을 공부할 때, 가장 어려웠던 부스팅 계열 알고리즘, 보아즈에서 발표를 하게 되면서 다시 한번 내용을 정리해두려고 한다. 학부생의 철없는 질문을 받아주신 건국대학교 권성훈

hyunlee103.tistory.com

'정형데이터' 카테고리의 다른 글

| CatBoost 모형 (0) | 2021.11.03 |

|---|---|

| Light GBM 모형 (0) | 2021.11.02 |

| Gradient boosting 모형 (0) | 2021.11.01 |

| Adaboost 모형 (0) | 2021.11.01 |

| boosting에 대하여 (0) | 2021.10.29 |