https://tech.kakao.com/posts/633

LLM, 더 저렴하게, 더 빠르게, 더 똑똑하게 - tech.kakao.com

안녕하세요. 카카오 기술전략 소속의 로빈입니다. 현재 저는 카카오의 AI 교육 자...

tech.kakao.com

1. LLM의 사용 가격은 지속적으로 낮아지고 있다

2023.05 gpt 3.5 turbo는 100만 토큰당 2달러였으나 2024.07 gpt 4o mini는 100만 토큰당 0.24달러

구글의 gemini도 이에 맞춰 가격 인하

Claude 역시 가격 인하

이러한 가격 인하 흐름은 오픈소스 모델의 API 가격 경쟁이 영향을 끼친 것으로 예상

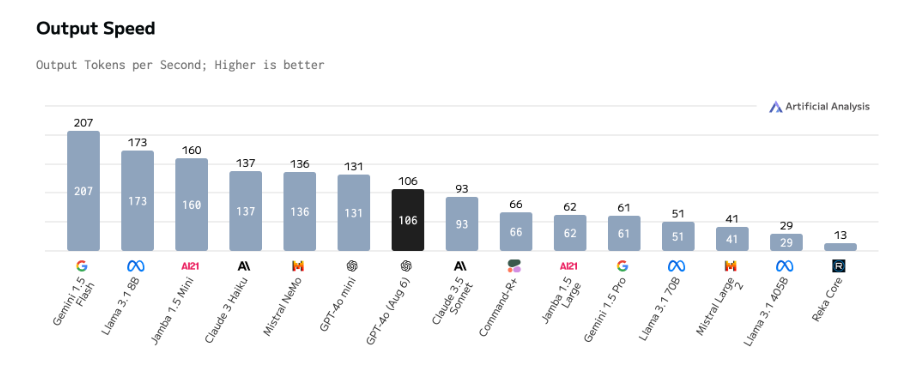

2. LLM은 점점 빨라진다

AI를 활용한 서비스를 구축할 시 LLM의 토큰 생성 속도는 프로젝트의 핵심 요소

토큰은 보통 음절 단위나 단어 수준

일반적으로 사람은 초당 30~50토큰 정도를 읽는데 기존 검색 엔진은 이보다 빠른 밀리초 단위로 수십~수백 토큰 단위로 결과를 제공

초기 LLM의 경우 사람이 읽는 속도보다 느리게 텍스트를 생성

현재 LLM은 GPT-4o는 초당 106토큰, mini는 초당 131토큰, gemini flash는 207토큰

당연히 토큰 생성 속도는 트래픽, 입력 데이터의 양, 처리 내용의 복잡성 등에 따라 변동

또한 모델 자체 뿐만 아니라 GPU같은 하드웨어의 성능에도 좌우

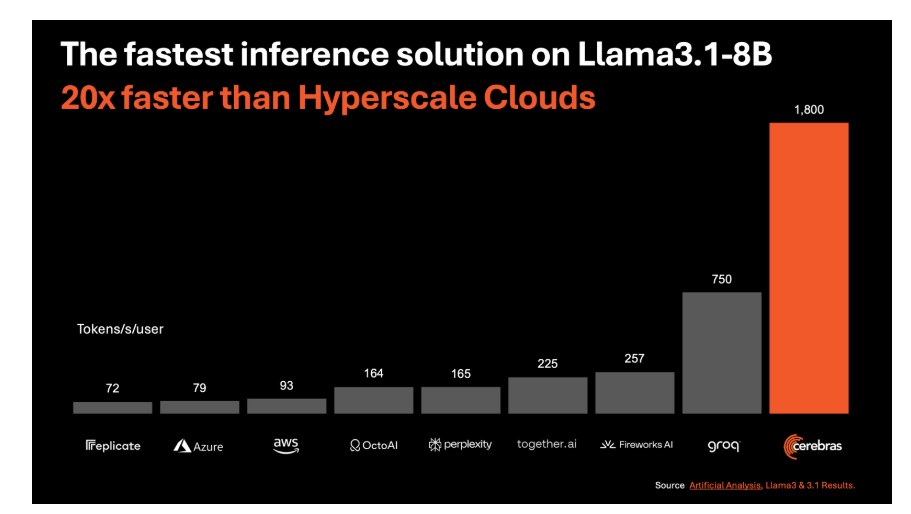

최근 Groq, Cerebras사의 AI모델에 특화된 커스텀 칩들이 등장하면서 더욱 빠른 생성 속도를 제공

이러한 빠른 속도는 스트리밍 방식이 아니어도 사용자가 불편없이 실시간으로 생성 결과를 확인할 수 있을 정도

이렇게 빠른 속도 덕분에 자율주행, 로봇 산업과 같은 실시간 대량 데이터 처리 기술이 필요한 분야에서 LLM의 활용 가능성이 확대

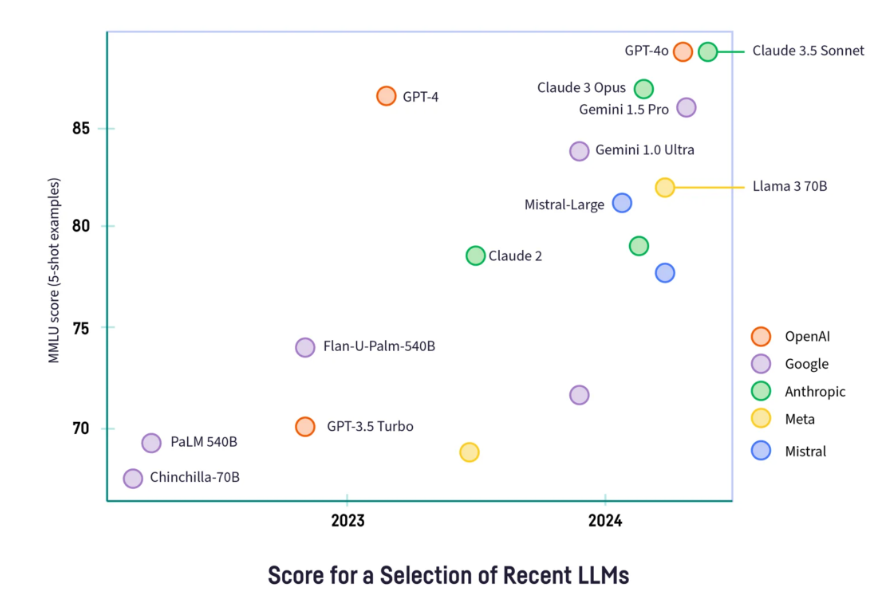

3. LLM이 더욱 똑똑해진다

2022.11 chatgpt 이후 gpt-4가 꾸준히 업데이트 되면서 gpt-4o에서 엄청난 성능 향상

Anthropic의 Claude 또한 버전 2에서 3으로 업하면서 3.5Sonnet은 SOTA모델

구글의 Gemini역시 업데이트 되면서 1.5pro가 가장 우수한 성능

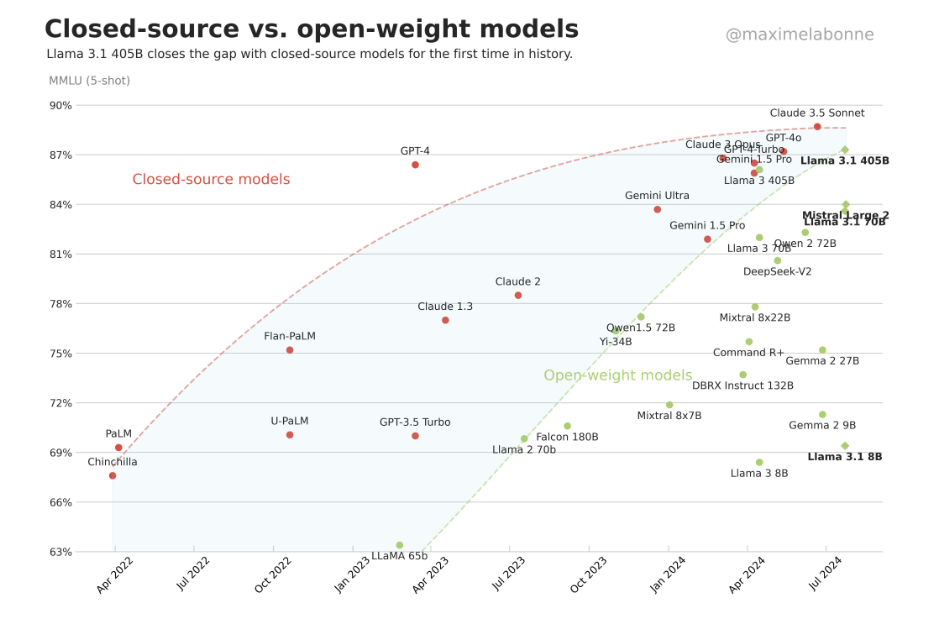

오픈소스 LLM들도 상용 LLM들의 성능을 빠르게 따라잡는중

Meta의 Llama 3.1 Alibaba의 Qwen2 등이 대표적인 오픈소스 모델이고,

GPU만 갖췄다면 GPT-4에 근접하는 LLM을 활용할 수 있음

Q-star로 알려진 openAI의 Strawberry는 흔히 접할 수 있던 단순한 챗봇을 넘어 복잡한 수학 문제와 프로그래밍 문제를

해결할 수 있는 추론 능력을 갖춘 혁신적인 모델로 발전할 것으로 예상

또한 이 모델은 GPT-5급 모델이라는 소문까지 도는 중

또한 OpenAI는 차세대 모델 Orion을 개발 중에 있고 완전한 gpt-5급 모델로 예상

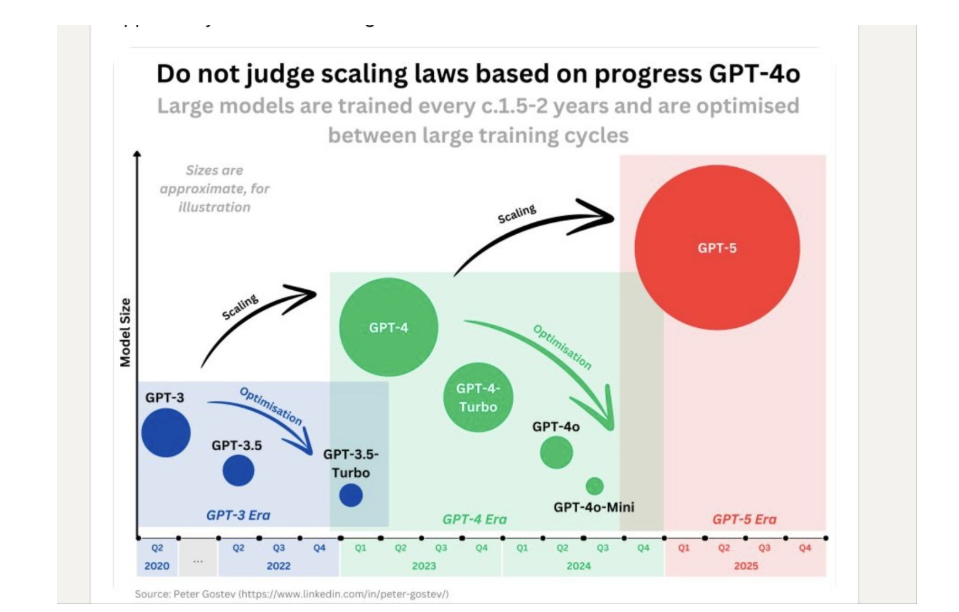

LLM은 최적화, 다른 한편으로는 규모 확장으로 지속적으로 발전

4. LLM이 읽는 단어가 늘어난다

GPT-3.5는 한번에 처리할 수 있는 입력이 4000토큰

GPT-4는 8000토큰

이후 36000토큰, 128000토큰까지 확장

Anthropic의 Claude는 2버전에 20만토큰

구글의 Gemini는 출시 당시부터 100만 토큰 처리, 내부에서는 1000만 토큰까지 처리할 수 있었다고함

24년 6월에 1.5pro는 200만 토큰까지 지원함

오픈소스 LLM중 Llama 3.1은 128000토큰, Qwen2는 별도의 agent 모델로 100만 토큰

최근 Magic사는 구글 클라우드와 협력하여 1억 토큰에 달하는 컨텍스트 윈도우를 갖춘 코드 어시스턴트를 개발하기 위해

새로운 구글 클라우드 기반의 슈퍼컴퓨터를 구축한다고 발표

1억 토큰은 모델이 750권 정도의 소설에 해당하는 양의 텍스트를 한번에 이해할 수 있다는 의미

이렇게 대규모 컨텍스트를 지원한다는 것은 LLM 모델이 더 많은 데이터를 한번에 처리할 수 있다는 것

지금도 제한된 컨텍스트 내에서 정확하게 정보를 이해하기 위한 RAG 기술들이 개발되고 있지만

컨텍스트 사이즈가 커지면서 RAG 기술이 필요없다는 전문가도 있다

혹은 컨텍스트 사이즈가 곧 비용이므로, 현재 RAG 기술이 더욱 고도화될 가능성도 높다

5. 경량 LLM(sLLM)이 유용해지고 있다

최근 AI 서비스 개발의 트렌드는 하나의 모델만 사용하는 대신 속도, 비용, 보안 및 구현 기능에 따라

여러 LLM을 하이브리드로 결합해 사용

Perplexity는 사용자의 쿼리를 빠르게 분석하는 sLLM을 앞단에 배치하여 사용자 의도를 정확하게 파악

이후 레퍼런스 요약, 전체 내용 생성 및 후속 질문 목록 생성 등 각 기능에 맞는 다른 LLM들을 결합하여 결과를 생성하는

하이브리드 구조로 운영

또한 다른 케이스들을 생각해보면

번역에 특화된 sLLM이나 빠른 응답을 위한 추론 중심의 sLLM을 활용하여 사용자 경험을 최적화할수도 있다

이렇게 모바일이나 노트북에 설치 가능한 on device 모델은 성능이 다소 떨어질 수 있지만

빠른 응답, 개인정보 보호 및 보안을 중시하는 환경에서 특정 도메인의 성능을 강화하여 유용하게 쓰일 수 있다

'딥러닝 > LLM' 카테고리의 다른 글

| LLM 기본4 - transformer + 텍스트 데이터의 토큰화 (0) | 2025.04.06 |

|---|---|

| LLM 기본3 - LLM 애플리케이션을 개발하기 위해 필요한 핵심 개념 (0) | 2025.03.31 |

| LLM 기본2 - ChatGPT가 나오기까지 (0) | 2025.03.27 |

| LLM 기본1 - 언어 모델링의 역사 (0) | 2025.03.03 |

| RAG(Retrieval-Augmented Generation)의 개념 간단하게 (0) | 2024.08.11 |