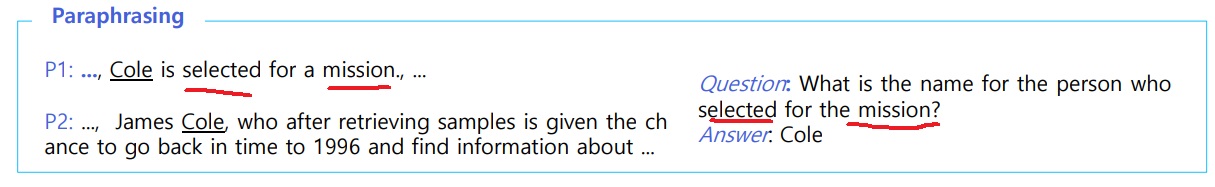

1. paraphrasing

단어들 구성이 동일하진 않지만 동일한 의미의 문장을 이해해야함

위에서 재미있는 부분은 P1과 P2 둘다 question에 대한 답을 가지고 있기는 한데 모델 입장에서는 P1을 이해하기 쉬워함

왜냐하면 question에 존재하는 selected와 mission이 직접적으로 P1에 존재해서 그럼

그러나 P2는 question에 존재하는 단어들과 직접적으로 matching되는 단어들이 존재하지 않음

다른 단어로 paraphrasing하면서 생기는 부분을 model이 이해하기 어려워함

2. coreference resolution

coreference란 그 사람, 그것같이 물건이나 사람 존재를 지칭하는 “참조”를 의미함

실제로 coreference같은 지시대명사가 나오면 그것이 무엇을 지칭하는지 이해하기 까다로운 경우가 많아

그럼에도 불구하고 그것이 무엇을 가리키는지 알아야 지문을 이해할 수 있어

3. unanswerable question

지문이 주어졌는데 질문에 대한 답이 지문 속에 주어지지 않는 경우

그러나 질문의 문법적, 의미적 요소때문에 모델이 보기에는 마치 지문에 답이 있는 것처럼 보이게 만들었음

제대로 모델을 만들었으면 정답을 주는 것이 아니라 답을 모르겠다는 no answer을 주어야함

위 그림에서 첫번째 질문의 경우 little opposition 대신에 살짝만 바꿔서 significant opposition으로 바꿔서 모델이 질문을 오해하기 쉽게 만들었다

model 입장에서는 opposition이 matching되는거 보고 later laws라고 대답을 내놓기 쉽다는 것임.

그러나 그것은 little opposition의 이야기지 significant opposition은 아니라서 오답

두번째 질문도 마찬가지인데 1937 treaty만 보고 근처에서 답이라고 생각하는 bald eagle protection act를 내놓았는데 이것은 1940년도 이야기라 오답임

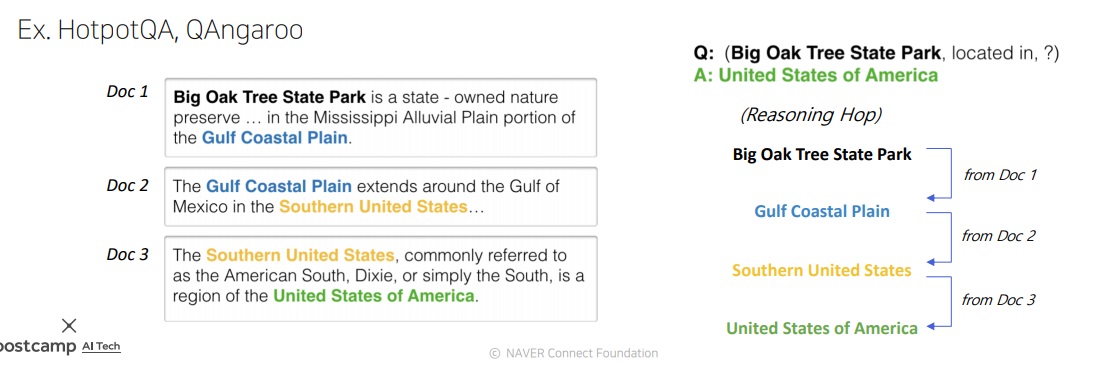

4. multi hop reasoning

최근에 중요하게 다뤄지는 문제

어떠한 질문에 답변을 내기 위해 경우에 따라서는 여러군데 퍼진 다양한 정보를 모아서 multi hop reasoning으로 답을 내놓아야함

무슨 말이냐면 문서 하나만 봐서는 답을 내놓기 어려워서 여러 문서를 참고해서 답을 내놓아야한다는 의미

hop은 무슨 의미인지 찾아보니 건너 뛰는 모습, 네트워크에서 출발지와 목적지 사이의 경로? 나아가 단락이라고 볼 수 있겠지

위 그림에서 big oak tree state park이 어디있는지 물어봤는데 doc1에서 gulf coastal plain에 있다고 밝혔고

doc2에는 gulf coastal plain이 southern united states에 있고 이것이 doc3에는 united states of america에 있다고 밝혀서

최종적으로 big oak tree state park이 united states of america라고 답을 내놓는다

'딥러닝 > Machine Reading Comprehension' 카테고리의 다른 글

| subword tokenizing, byte pair encoding 간단하게 알아보기 (0) | 2024.03.03 |

|---|---|

| Machine reading comprehension metric 종류 (0) | 2024.03.02 |

| Machine reading comprehension 개요 (0) | 2024.03.01 |

| in batch negative를 이용한 dense embedding encoder modeling (0) | 2022.05.26 |

| dense embedding encoder modeling -개요와 학습방법- (0) | 2022.05.26 |