1. deep compression

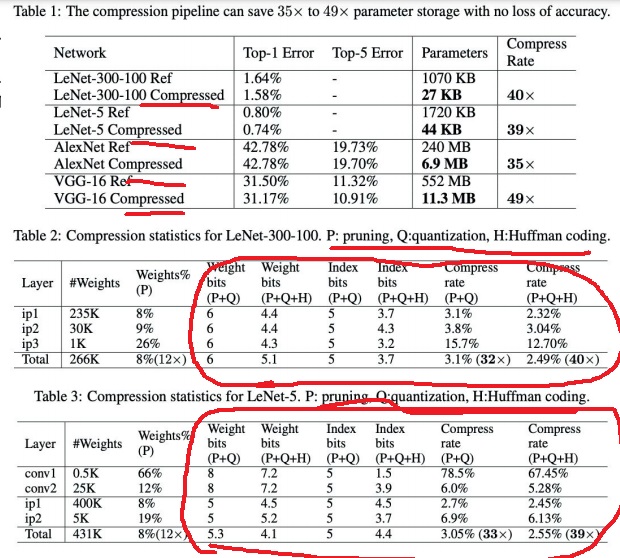

pruning과 quantization, huffman coding을 적절히 조합하여 model을 compression하는 기법을 소개

performance가 기존 모델과 비슷하면서도 압도적으로 parameter수를 줄였음

error는 기존 모델과 비슷한데 parameter수가 40배정도 감소시킨 당시 획기적인 논문

특정 모델에서 layer 단위에서도 compression시켜봄?

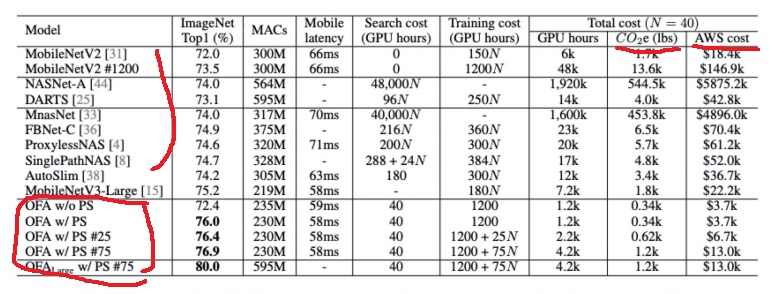

2. Once for all

once-for-all network는 서로 다른 depth, width, resolution등을 가진 network의 조합

이런 network의 조합들을 서로 간섭없이 한번에 training하고

target device마다 적절한 sub network를 선정하여 분배하는 방식

다른 모형들에 비해 성능은 좋고 cost는 줄어들었으며 여러 방면으로 개선되었다는 것

CO2와 AWS cost도 있다는 것이 눈에 띈다

AWS cost는 AWS라는 cloud 환경에서 모델을 돌릴때 드는 비용인가봄

MACs는 multiply accumulate operation으로 계산비용

3. size와 performance

size가 크다고해서 performance가 좋은 것은 아니고

모델의 고유 특성으로 인해 계산비용이 반드시 큰 것도 아님

VGG는 model size가 큰데 성능은 중간쯤에 있음

또 계산비용(FLOP)이 다른 작은 모델(NAS)보다 적게 드는 경우도 있음

4. metric

Top 1 accuracy는 모델이 1번 prediction한 것이 정확히 정답인지 측정

Top 5 accuracy는 모델이 5번 prediction한 것 중 적어도 하나가 정답이면 전부 정답으로 인정함

FLOPS는 floating point operations per second로 컴퓨터가 1초당 수행하는 부동소수점 연산 횟수(대문자 S)

FLOPs는 floating point operations라고 함(소문자 s)

얼마나 많은 계산을 수행하느냐를 말하니까 계산비용을 뜻함

표준적으로 자주 사용하는 metric으로 top1,top5 accuracy, latency 등등이 있지만

논문에서 강조하고 싶은 부분에 따라 사용하는 metric은 다름

'딥러닝 > light weight modeling' 카테고리의 다른 글

| NAS(Neural Architecture Search) 기법에 대해 알아보기 (0) | 2022.03.20 |

|---|---|

| 딥러닝 모델의 hyperparameter search (0) | 2022.03.15 |

| model compression에서 고려되는 특이한 제약조건들 (0) | 2022.03.05 |

| model compression이란 무엇인가? (0) | 2022.03.04 |

| edge intelligence 완전 파헤치기 (0) | 2022.03.03 |